Künstliche Intelligenz (KI) hat das Potenzial, das Gesundheitswesen positiv zu verändern und bietet Chancen in der personalisierten und präziseren Medizin, aber auch Unterstützung bei verschiedensten Verwaltungsprozessen. Neben diesen Möglichkeiten müssen natürlich auch ethische und regulatorische Rahmenbedingungen geschaffen werden, damit der Einsatz von KI sicher ist. Vor diesem Hintergrund hat die EU die EU-KI-Verordnung (AI Act) verabschiedet. Diese Verordnung ist am 1. August 2024 in Kraft getreten und soll einen sicheren, einheitlichen Rahmen für den Einsatz von KI schaffen und verantwortungsvolle Nutzung und Entwicklung von KI in der EU fördern. Sie ist insbesondere auf die potenziellen Risiken von KI für Gesundheit, Sicherheit und Grundrechte ausgerichtet und legt klare Anforderungen fest, die KI-Entwickler und -Betreiber je nach Anwendungsfall erfüllen müssen. Für das Gesundheitswesen ist der AI Act besonders relevant, da er direkt beeinflusst, wie KI-Lösungen im Gesundheitsbereich entwickelt und eingesetzt werden dürfen.

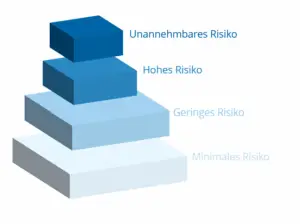

Diese Verordnung verfolgt einen risikobasierten Ansatz, wobei KI-Anwendungen je nach dem jeweiligen Gefährdungspotenzial in vier Risikostufen eingeteilt werden. Für jede Risikostufe gelten unterschiedliche Auflagen und prinzipiell gilt, je höher das Risiko, desto strenger die Anforderungen.

Unter die Einstufung „Minimales Risiko“ fallen recht einfache KI-Systeme wie Spamfilter oder KI-gestützte Videospiele. Sie gelten als wenig riskant und unterliegen keinen besonderen Verpflichtungen. Anbieter können hier beispielsweise freiwillig Verhaltensempfehlungen einführen, sind aber nicht dazu verpflichtet. Für KI-Systeme in der Stufe „Geringes/Begrenztes Risiko“ sind für einige Anwendungen besondere Transparenz vorgeschrieben. So müssen beispielsweise Chatbots Nutzer deutlich darauf hinweisen, dass sie es mit einer Maschine interagieren. Aber auch durch KI generierte Inhalte (etwa Deep Fakes) müssen als solche gekennzeichnet werden. Solche Kennzeichnungspflichten unterstützen, dass Benutzer KI-Ergebnisse richtig einordnen und nicht getäuscht werden.

In die Kategorie „Hohes Risiko“ fallen KI-Systeme, die als hochriskant eingestuft werden. KI, die im Gesundheitswesen eingesetzt wird, unterliegt strengen Auflagen. Hierzu zählen unter anderem Anforderungen an Risikominimierungssysteme, hochwertige und möglichst unverzerrte Datensätze, umfassende Dokumentation, klare Informationen für die Nutzer und angemessene menschliche Aufsicht. Systeme in kritischen Bereichen wie Gesundheit, kritische Infrastruktur, Strafverfolgung und Bildung fallen typischerweise in diese Kategorie.

„Unannehmbares Risiko“ beschreibt KI-Anwendungen, die eine klare Bedrohung für die Sicherheit oder Grundrechte der Menschen darstellen und sind verboten. Darunter fallen zum Beispiel KI-Systeme zum Social Scoring, die das Verhalten oder persönliche Merkmale von Personen erfassen und bewerten würden.

Aus der risikobasierten Einstufung ergeben sich je nach Kategorie spezifische Pflichten. Wichtig ist, dass nicht alle Regelungen sofort gelten, denn der AI Act sieht eine gestaffelte Umsetzung vor. Einige Bestimmungen wie die Verbote besonders riskanter KI-Anwendungen und neue Aufklärungspflichten gelten bereits seit Februar 2025. Die meisten anderen Vorgaben für Hochrisiko-Systeme werden nach einer Übergangszeit von 2 Jahren ab Inkrafttreten verpflichtend (also ab August 2026). Die Regeln für bereits regulierte Hochrisiko-Produkte (beispielsweise Medizinprodukte) gelten erst ab 2027. Diese gestaffelte Einführung soll allen Beteiligten Zeit geben, sich auf die neuen Vorgaben einzustellen.

KI-Systeme kommen hier nicht nur mit besonders sensiblen Patientendaten in Kontakt, sondern können durch Unterstützung bei der Diagnosestellung oder Therapieempfehlungen direkten Einfluss auf das Leben von Menschen nehmen. Daher erfüllen Anwendungen wie KI-basierte medizinische Software zur Diagnose, Überwachung oder Behandlung in der Regel die Kriterien für Hochrisiko-KI, zumal viele solcher Systeme auch als Medizinprodukt gelten und einer Konformitätsbewertung unterliegen müssen.

Organisationen im Gesundheitswesen, die solche KI-Anwendungen einsetzen oder entwickeln, müssen alle Auflagen für Hochrisiko-Systeme konsequent erfüllen und unterliegen meist einer regelmäßigen Berichtspflicht gegenüber Behörden. Neben der Einhaltung bestehender Datenschutzgesetze wie die Datenschutzgrundverordnung (DSGVO) betont die Verordnung ausdrücklich den Schutz personenbezogener Daten. Denn KI-Systeme, die Gesundheitsdaten verarbeiten, müssen höchste Datenschutzstandards einhalten, damit die Privatsphäre der Patienten geschützt bleibt.

Konkret verlangt der EU AI Act für hochriskante KI-Systeme im Medizinbereich unter anderem folgende Maßnahmen und Nachweispflichten.

Die Datenqualität ist von äußerst hoher Bedeutung für die Genauigkeit einer KI. Daher müssen verwendete Daten fortlaufend auf Transparenz, hohe Qualität und Freiheit von Verzerrungen geprüft werden. Die Quellen der Trainings- und Eingabedaten sind genau zu dokumentieren und auf Verlangen offenzulegen. So soll beispielsweise Bias oder Fehlerquellen nachvollziehbar sein. Betreiber müssen ein kontinuierliches Risikomanagementsystem implementieren, das potenzielle Risiken des KI-Einsatzes identifiziert, bewertet und minimiert. Das soll dabei helfen, neue Risiken frühzeitig zu erkennen.

Außerdem ist eine umfassende technische Dokumentation zu erstellen und stets aktuell zu halten. Darin müssen Aufbau, Funktionsweise und Zweck des KI-Systems detailliert beschrieben sein, sodass Aufsichtsbehörden die Konformität prüfen können.

Bevor ein Hochrisiko-KI-System zum Verkauf angeboten oder genutzt wird, muss eine offizielle Konformitätsbewertung erfolgen. Diese Überprüfung durch zuständige Behörden stellt sicher, dass das System alle gesetzlichen Anforderungen erfüllt, bevor es Patienten oder Anwendern zur Verfügung steht. Hochrisiko-KI-Systeme müssen zudem in einer speziellen EU-Datenbank registriert sein, bevor sie auf den Markt gebracht oder klinisch eingesetzt werden dürfen. Diese Datenbank soll Transparenz schaffen und den Marktüberwachungsbehörden einen Überblick über zugelassene KI-Systeme geben.

KI soll die menschliche Expertise nicht ersetzen, sondern gezielt unterstützen. Der AI Act schreibt daher vor, dass hochriskante KI-Systeme grundsätzlich unter menschlicher Aufsicht stehen müssen. Das medizinische Fachpersonal bleibt daher verpflichtet, KI-Ergebnisse zu prüfen, zu bewerten und Unstimmigkeiten zu erkennen. Kommt es durch eine KI zu einem Fehler in der Behandlung, liegt die Verantwortung weiterhin bei Menschen, also bei Klinik oder Fachpersonal. Der AI Act verpflichtet Betreiber deshalb, klare Vorgaben zu erfüllen (Art. 26), um ihrer Sorgfaltspflicht gerecht zu werden.

Gesundheitseinrichtungen sollten interne Verantwortlichkeiten festlegen: Wer prüft die KI-Entscheidungen? Wer meldet Probleme? So lässt sich die Verantwortungslücke vermeiden, wenn KI „mitentscheidet“. Zudem betont der AI Act die Qualifikation des Personals, denn medizinisches Fachpersonal, das mit KI-Systemen arbeitet, muss über ausreichende Kompetenz im Umgang mit KI verfügen. Das bedeutet nicht, die Algorithmen im Detail zu verstehen, aber nachvollziehen zu können, wie die KI zu ihren Schlüssen kommt, wo ihre Grenzen liegen und wie die Ergebnisse fachlich einzuordnen sind. Um das zu fördern, sind Schulungen und Weiterbildungen zum Thema KI essenziell.

Wenn in der Behandlung oder Diagnose KI zum Einsatz kommt, muss medizinisches Personal den Patienten darüber informieren. Zudem haben Patienten ein Recht, KI-gestützte Entscheidungen anzufechten und können eine zusätzliche Überprüfung durch einen Menschen verlangen. Ärzte sollten Patienten proaktiv aufklären, wann beispielsweise ein Diagnosevorschlag aus einer KI stammt und ihre Fragen dazu beantworten. Die Transparenz- und Aufklärungspflichten sind zentrale Säulen der KI-Verordnung im Gesundheitsbereich und dienen dem Ziel, dass KI-gestützte medizinische Entscheidungen nachvollziehbar und vertrauenswürdig sind.

Wie erwähnt, gelten viele der Pflichten nicht sofort, sondern erst nach bestimmten Übergangsfristen. Diese gestaffelte Implementierung gibt dem Gesundheitswesen die Gelegenheit, sich vorzubereiten. Krankenhäuser und Unternehmen sollten die Zeit daher aktiv nutzen, um Compliance-Strukturen aufzubauen und interne Audits für KI-Anwendungen durchzuführen, Datenbestände zu bereinigen und Mitarbeiter zu schulen. Im Gesundheitswesen soll KI effizientere Diagnostik und personalisierte Therapien bis hin zu einer insgesamt besseren medizinischen Versorgung ermöglichen. Gleichzeitig bleiben grundlegende Werte wie Patientensicherheit, Transparenz und Datenschutz durch Verordnungen wie den AI Act bestehen, sodass Akzeptanz und Vertrauen in KI entstehen kann.

Der EU AI Act ist ein Teil der regulatorischen Anforderungen, die beim Einsatz von KI im Gesundheitswesen zu berücksichtigen sind. Die Medical Device Regulation (MDR) für KI-Systeme mit medizinischer Zweckbestimmung und die Datenschutzgrundverordnung (DSGVO) beim Umgang mit sensiblen Patientendaten sind aber ebenso von großer Bedeutung.

Wer KI im Krankenhaus strategisch und rechtssicher einführen will, muss also nicht nur den AI Act im Blick haben, sondern auch verstehen, wann KI als Medizinprodukt gilt, welche Datenschutzpflichten greifen und welche Verantwortung Kliniken selbst tragen.

There are no results matching your search

There are no results matching your search

There are no results matching your search

Willkommen bei unserem exklusiven Support für Bestandskunden. Hier finden Sie alle nötigen Informationen, um schnell und unkompliziert Hilfe bei technischen Anfragen zu erhalten.

Senden Sie uns Ihr Anliegen mit allen relevanten Details an:

Für eine direkte Unterstützung per Fernwartung, laden Sie bitte unser TeamViewer-Modul herunter:

Bitte beachten Sie: Dieser Kanal ist speziell für technische Anfragen unserer Bestandskunden vorgesehen. Für allgemeine Anfragen, Informationen zu unseren Dienstleistungen oder eine Erstberatung nutzen Sie bitte unser Kontaktformular oder schreiben Sie eine E-Mail an info@rewion.ucepts.de.