Mit der erweiterten macOS-Unterstützung geht Automation Anywhere deshalb einen konsequenten Schritt in Richtung echter Plattformoffenheit. Doch was bedeutet das für Unternehmen und ihre Automatisierungsstrategie?

Die Realität in Unternehmen hat sich verändert: Prozesse enden nicht mehr an Betriebssystemgrenzen. Mitarbeitende arbeiten auf Windows, macOS, mobilen Geräten und webbasierten Plattformen oft innerhalb derselben Prozesskette.

Daraus folgt:

Wenn ein kritischer Prozessschritt ausschließlich auf macOS stattfindet, kann der Automatisierungsgrad des Gesamtprozesses drastisch sinken. Genau hier setzt plattformübergreifende Automatisierung an.

Die Unterstützung von macOS ist nicht nur eine technologische Ergänzung, sondern Teil einer größeren architektonischen Entwicklung: Automatisierung soll überall dort funktionieren, wo Mitarbeitende tatsächlich arbeiten.

Die Erweiterung ermöglicht:

Damit wird Automatisierung nicht länger an die Infrastruktur gebunden, sondern zu einer universellen Fähigkeit innerhalb der IT-Architektur.

Viele Unternehmensprozesse verlaufen heute über mehrere Ebenen:

Die Einbindung von macOS sorgt dafür, dass diese Prozessketten nicht an Betriebssystemgrenzen auseinanderfallen.

Vorteile:

Insbesondere in hybriden Umgebungen kann der Automatisierungsgrad dadurch signifikant steigen.

Trotz aller neuen Möglichkeiten bringt macOS im Vergleich zu Windows andere technische und sicherheitsrelevante Rahmenbedingungen mit, darunter:

Damit macOS-Automatisierung nachhaltig funktioniert, muss sie in bestehende Sicherheits-, Betriebs- und Architekturmodelle eingebettet werden.

Die macOS-Unterstützung bei Automation Anywhere ist ein logisch konsequenter Schritt, da Arbeitsumgebungen zunehmend heterogen werden. Sie schafft die Grundlage für wirklich plattformübergreifende End-to-End-Automatisierung und adressiert damit eine der größten praktischen Hürden moderner Prozesslandschaften.

Der Mehrwert entsteht jedoch erst dann, wenn Unternehmen diese Fähigkeit strategisch, architektonisch und organisatorisch einbetten. In diesem Kontext kann macOS-Automatisierung ein wichtiger Hebel für Stabilität, Effizienz und durchgängige Automatisierungserlebnisse sein.

Mit Automation Anywhere V39 KI-Automatisierung erweitert die Automation-360-Plattform gezielt ihre Funktionen für Künstliche Intelligenz. Ziel ist es, Automatisierungen schneller, transparenter und leichter wartbar zu gestalten. V39 richtet sich insbesondere an Anwenderunternehmen, IT-Architekten und Automatisierungsverantwortliche, die ihre IT-Landschaften mit intelligenten Automatisierungen ergänzen möchten.

Im Fokus stehen:

KI-gestützte Entwicklung für Entwickler und Fachanwender

Verbesserte Dokumentenverarbeitung

Transparenter Betrieb verteilter Automatisierungslandschaften

Integration in hybride ERP- und IT-Umgebungen

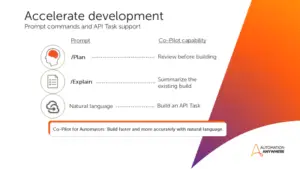

Co-Pilot für Automators wurde in V39 erheblich erweitert:

Plan-Modus: Wandelt Anforderungen in strukturierte, editierbare Automatisierungspläne um – ideal für Review und Teamabstimmung vor dem Build.

Explain-Funktion: Liefert verständliche Schritt-für-Schritt-Erklärungen für bestehende Automatisierungen – vereinfacht Debugging, Übergaben und Wartung.

API-Task-Support: Erlaubt das Erstellen, Bearbeiten und Aktualisieren von API-basierten Workflows per natürlicher Sprache.

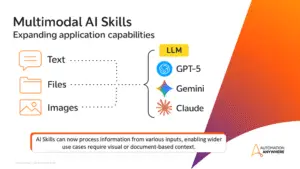

Multimodale AI Skills unterstützen nun Text, Bilder und Dateien und ermöglichen komplexe Szenarien wie Schadensanalysen, Dokumentenverarbeitung und visuelle Workflows. Entwickler können flexibel zwischen LLMs wie GPT-5, Gemini und Claude wählen.

Automator AI reduziert damit manuellen Entwicklungsaufwand, verbessert Konsistenz und beschleunigt hybride Integrationen zwischen Legacy-Software, Cloud-Services und externen Anwendungen.

V39 bringt erweiterte Funktionen für den Betrieb und die Analyse von Automatisierungen:

Process Metrics Dashboard: Überblick über Erfolgsquoten, Laufzeiten, Trends und Aging von Automatisierungen – mit Filter- und Exportfunktionen.

Mozart Orchestrator: Leistungsfähige Prozess-Orchestrierung, u.a. Universal Event Listener für Echtzeit-Auslöser in beliebigen Apps oder Systemen.

Agent Interoperability: Sichere, parallele Ausführung über mehrere Geräte und Plattformen; nahtlose Multi-Agent-Orchestrierung mit Governance und RBAC.

Diese Features sorgen für höhere Stabilität, schnellere Reaktionszeiten und bessere Analysefähigkeit in komplexen Automatisierungslandschaften.

Die Document Automation wurde in V39 stark erweitert:

Google Gemini Modelle auf AWS und GCP: Ermöglichen generative KI-gestützte Datenextraktion, unabhängig vom zertifizierten Cloud-Anbieter.

Effiziente Verarbeitung großer, unstrukturierter Dokumente

Unterstützung mehrsprachiger Dokumente

Verarbeitung komplexer Layouts

Schnellere und genauere Extraktion

Unterschied Oberfläche Document Automation V39

Version History in Test Mode: Verbesserungen ermöglichen sichere Änderungen an Lerninstanzen, automatische Validierung und korrekte Anzeige aller Versionen.

Fehlerbehebungen: Korrekte Extraktion deutscher Zeichen, Unterstützung asiatischer Zeichensätze, fehlerfreie Anpassungen von Standard Forms Projekten, stabile Adaptive Search Queries.

Generative Co-Pilot Validierung: Fehlende Signaturfelder werden korrekt erkannt und validiert.

Vorteile:

Reduzierter manueller Aufwand bei dokumentenintensiven Prozessen

Höhere Datenqualität und Genauigkeit

Flexibilität bei der Nutzung von Lerninstanzen auf verschiedenen Cloud-Plattformen

Bekannte Einschränkungen: Einige spezielle Szenarien im Testmodus, mit regulären Ausdrücken oder sehr langen Dateinamen müssen beachtet werden; Workarounds sind dokumentiert.

Die neue Version erleichtert Fachanwendern die Nutzung von Automatisierungen:

Einbettung direkt in Geschäftsanwendungen über iFrame-Widgets

Steuerung via natürlicher Sprache durch verbesserte Konversationsfunktionen

Erweiterte Wissensbasis für präzisere Automatisierungsanfragen

Das senkt die Einstiegshürde für nicht-technische Anwender und steigert die Nutzung von Automatisierungen im Fachbereich.

V39 ergänzt kontrollierte Zugriffe auf KI-Funktionen:

Generative Recorder: Zentral steuerbar und mit rollenbasierten Berechtigungen

Unterstützung für LLMs wie GPT-5, Gemini und Claude

Zugriffskontrolle und Governance über das Control Room Management

Damit wird die Zusammenarbeit zwischen Entwicklung, Betrieb und Compliance gestärkt.

Automation Anywhere V39 KI-Automatisierung vereint:

Schnellere, smartere Entwicklung

Stabilen, transparenten Betrieb

Einfache Einbindung von Fachanwendern

Besonders geeignet ist es für Unternehmen mit komplexen ERP-Landschaften, hybriden IT-Architekturen und datenintensiven Prozessen. V39 verbessert die Effizienz, Qualität und Steuerbarkeit von Automatisierungen, ohne Governance oder Nachvollziehbarkeit zu vernachlässigen.

Viele Unternehmen nutzen heute die Cloud, doch zwischen „Cloud nutzen“ und „Cloud richtig nutzen“ können Welten liegen. Während einige ihre Cloud-Infrastruktur als strategischen Vorteil einsetzen, kämpfen andere mit ineffizienten Systemen, steigenden Kosten und starren Strukturen. Der Unterschied liegt unter anderem in der Architektur: Wer von Anfang an auf eine durchdachte Cloud-Architektur setzt, schafft die Grundlage für Skalierbarkeit, Sicherheit und Effizienz. In diesem Artikel zeigen wir, was für den Aufbau einer Cloud-Architektur wichtig ist und wie die verschiedenen Ebenen zusammenwirken.

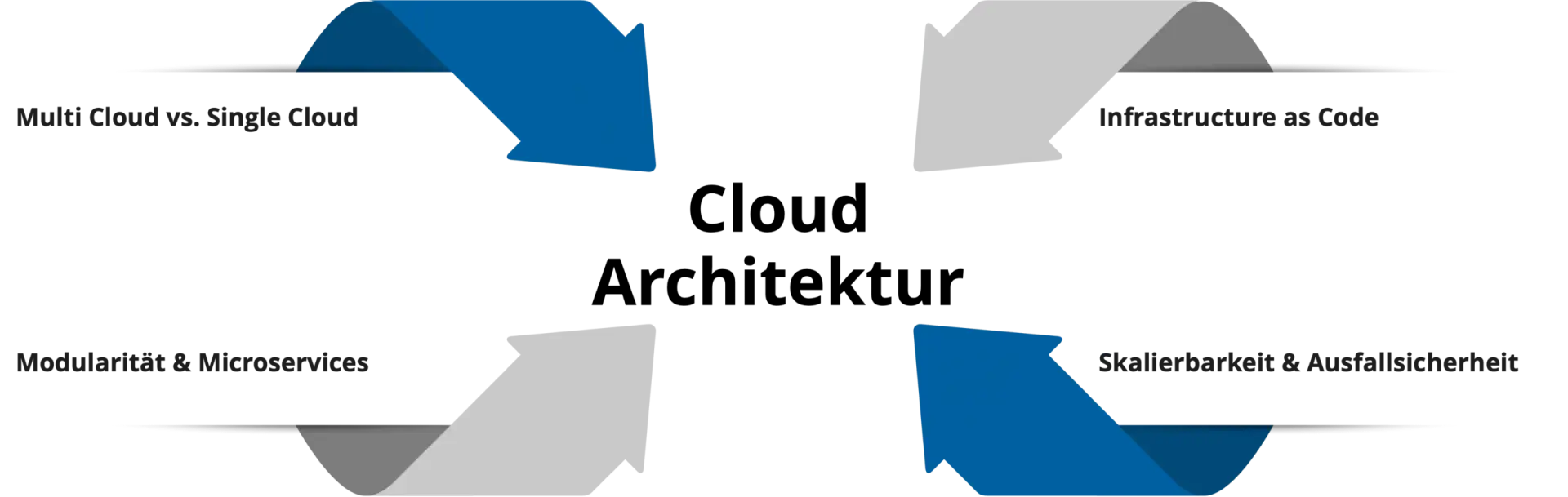

Eine zukunftssichere Cloud-Architektur entsteht durch bewusste Entscheidungen auf verschiedenen Ebenen. Von der grundlegenden Cloud-Strategie über die Anwendungsstruktur bis hin zur Automatisierung und Betriebsstabilität. Jede Ebene baut auf der vorherigen auf und trägt zum Gesamterfolg bei. Die folgenden vier Dimensionen bilden das Fundament einer leistungsfähigen Cloud-Plattform, die mit Ihrem Unternehmen wachsen kann.

Eine der ersten Fragen beim Aufbau einer Cloud-Architektur lautet: Setzen wir auf einen einzigen Cloud-Anbieter oder verteilen wir unsere Workloads auf mehrere? Beide Ansätze haben eigene Vor- und Nachteile.

Die richtige Wahl hängt von Ihren Anforderungen ab: Unternehmen mit hohen Compliance-Anforderungen oder dem Wunsch nach Souveränität tendieren zu Multi-Cloud-Ansätzen. Wer Effizienz und schnelle Markteinführung priorisiert, fährt mit einem Single-Cloud-Ansatz oft besser. Wichtig ist: Die Entscheidung sollte strategisch getroffen werden, nicht zufällig oder nach dem Bauchgefühl.

Moderne Cloud-Architekturen setzen auf Modularität statt auf monolithische Anwendungen. Das Microservices-Prinzip zerlegt komplexe Anwendungen in kleinere, eigenständige Services, die unabhängig voneinander entwickelt, deployed und skaliert werden können.

Die Vorteile liegen auf der Hand: Teams können parallel arbeiten, einzelne Komponenten lassen sich gezielt skalieren und Technologiewechsel betreffen nur Teilbereiche statt des gesamten Systems. Wenn beispielsweise der Payment-Service mehr Last erfährt als der Rest der Anwendung, skaliert nur dieser und nicht die gesamte Infrastruktur.

Allerdings bringt diese Flexibilität auch Herausforderungen mit sich. Microservices erfordern kleinteilige Orchestrierung, durchdachtes API-Design und robustes Monitoring. Microservices erfordern eine sichere und kostenbewusste Konfiguration aller Services und ihrer Interaktionen. Container-Technologien wie Kubernetes oder Cloud Foundry helfen dabei, diese Komplexität zu meistern. Für Cloud Platform Engineering sind Microservices ideal, weil sie genau die Selbstverwaltung und Autonomie ermöglichen, die Teams brauchen.

Infrastructure as Code (IaC) ist das Fundament jeder modernen Cloud-Architektur. Statt Server und Netzwerke manuell zu konfigurieren, wird die gesamte Infrastruktur in Code beschrieben. Dadurch wird sie versioniert, testbar und reproduzierbar. Darüber hinaus ermöglicht IaC alle Vorteile etablierter Softwareentwicklungs-Workflows. Änderungen können vor dem Merge geprüft, dokumentiert und freigegeben werden, Konfigurationen automatisiert getestet werden, und fehlerhafte oder unsichere Setups lassen sich erkennen, bevor sie in produktive Umgebungen ausgerollt werden.

Tools wie Terraform, Pulumi, Azure Bicep oder AWS CloudFormation ermöglichen es, Infrastruktur wie Software zu behandeln. Die Vorteile dahinter sind groß:

In Kombination mit GitOps entsteht ein besonders leistungsfähiger Ansatz: Infrastruktur-Änderungen werden ausschließlich über Git-Workflows gesteuert und von CI/CD-Pipelines automatisiert ausgerollt. Das beschleunigt Prozesse und erhöht die Sicherheit, da manuelle Eingriffe auf ein Minimum reduziert werden.

Ein zukunftssicherer Aufbau einer Cloud-Architektur muss zwei zentrale Anforderungen erfüllen: Er muss mit wachsenden Anforderungen skalieren und gleichzeitig hochverfügbar bleiben.

Wichtig ist aber: Hochverfügbarkeit hat ihren Preis. Unternehmen müssen abwägen, welche Systeme kritisch sind und welches Ausfallrisiko akzeptabel ist. Nicht jede Anwendung braucht eine >99,99%-Verfügbarkeit.

Erst das Zusammenspiel aller Elemente stellt den erfolgreichen Aufbau einer Cloud-Architektur dar. Eine durchdachte Cloud-Architektur kombiniert die richtige Cloud-Strategie mit modularem Design, automatisierter Infrastruktur und eingebauter Resilienz. Unterstützen können dabei spezielle Frameworks wie das AWS, Google oder Azure Well-Architected Framework sowie Cloud Adoption Frameworks. Diese definieren Best Practices für Sicherheit, Kostenoptimierung, Betrieb und Performance. Durch den Security by Design Ansatz sorgen sie zudem dafür, dass Sicherheit von Beginn an berücksichtigt und integriert wird.

Weiterhin wichtig ist FinOps für eine kontinuierliche Kostenoptimierung. Cloud-Ressourcen sind zwar flexibel, können aber ohne Kontrolle schnell zu Kostenexplosionen führen. Monitoring, Tagging und regelmäßige Reviews sind dazu da, ein gutes Verhältnis zwischen Performance und Wirtschaftlichkeit zu schaffen.

Im Cloud Platform Engineering geht es vor allem darum, die Cloud-Infrastruktur als Produkt zu verstehen. Sie ist eine Plattform, die kontinuierlich an die Bedürfnisse der Nutzer angepasst wird. Die optimale Cloud-Architektur gibt es deshalb nicht als Standardlösung. Jedes Unternehmen muss basierend auf seinen Anforderungen, Ressourcen und Zielen die individuell richtigen Entscheidungen treffen. Ob Single- oder Multi-Cloud, Microservices oder modulare Monolithen, umfassende Redundanz oder akzeptables Risiko, die Architektur muss zur Organisation passen.

Wichtig ist, ein Verständnis für die grundlegenden Prinzipien zu schaffen. Infrastructure as Code ermöglicht Automatisierung, Flexibilität entsteht durch Modularität und durchdachte Skalierbarkeit und Ausfallsicherheit bringen Resilienz. Durch die Berücksichtigung dieser Elemente können Unternehmen eine zukunftssichere Cloud-Architektur schaffen, die mit dem Unternehmen wächst.

Nach Jahren des infrastrukturellen Aufbaus zeigt sich 2025 deutlich, dass digitale Anwendungen der Telematikinfrastruktur im Versorgungsalltag angekommen sind. Der E-Health Monitor 2025 belegt, dass die Nutzung zentraler TI-Anwendungen insgesamt zunimmt. Gleichzeitig wird sichtbar, dass sich Nutzungsintensität und Integration aber je nach Anwendung unterscheiden.

Das E-Rezept ist die bislang am weitesten verbreitete Anwendung der Telematikinfrastruktur. Laut E-Health Monitor 2025 hat sich das digitale Rezept mit einem Anteil von 90,2 Prozent an allen eingelösten Rezepten innerhalb kurzer Zeit als Standard etabliert. Die Zahl der eingelösten E-Rezepte ist seit der verpflichtenden Einführung stark gestiegen und liegt aktuell bei 1,1 Milliarden eingelösten Rezepten.

Ein zentraler Erfolgsfaktor ist die klare Prozesslogik. Verordnung, Übermittlung und Einlösung folgen einem klar abgegrenzten Ablauf mit unmittelbarem Nutzen für alle Beteiligten. Das spart Zeit und Kosten und der Zugang zu Medikamenten wird erleichtert. Trotz der Vorteile werden weiterhin rund 10 Prozent der Rezepte ausgedruckt. Gründe hierfür sind vor allem technische Probleme innerhalb der Telematikinfrastruktur sowie die eingeschränkte Nutzbarkeit des E-Rezepts in der Haus- und Heimversorgung. Das Beispiel verdeutlicht, dass selbst bei sehr hoher Nutzung technische Stabilität und Prozessabdeckung entscheidend bleiben.

Neben dem E-Rezept verzeichnete auch die elektronische Arbeitsunfähigkeitsbescheinigung im Erhebungszeitraum des E-Health Monitors einen deutlichen Zuwachs. So stieg die Zahl der elektronisch übermittelten Arbeitsunfähigkeitsbescheinigungen von 304 auf 370 Millionen, was einem Anstieg von rund 22 Prozent entspricht. Die eAU gilt als fest etablierte Anwendung, insbesondere im ambulanten Bereich, da sie von mehr als 95% der Arztpraxen genutzt wird.

Die elektronische Patientenakte ist bundesweit im Betrieb und gilt als zentrales Element der TI-Anwendungen. Die Zahl der durch medizinische Einrichtungen geöffneten elektronischen Patientenakten ist laut E-Health Monitor 2025 innerhalb kurzer Zeit von rund 200.000 auf 7,2 Millionen gestiegen.

Gleichzeitig zeigt ein Blick auf die aktive Nutzung ein differenzierteres Bild. Lediglich rund 4 Prozent der Versicherten verfügten im Erhebungszeitraum über eine GesundheitsID. Der Unterschied zwischen angelegten und tatsächlich genutzten Akten ist damit erheblich. In vielen Fällen bleiben die Akten leer oder nur geringfügig befüllt, sodass der erwartete Nutzen der ePA bislang nur eingeschränkt realisiert wird.

Obwohl durch das Opt-out-Verfahren eine Abdeckung von über 80 Prozent erreicht wurde und nur etwa 5 Prozent der Versicherten widersprochen haben, entsteht Mehrwert erst durch tatsächliche Nutzung und Befüllung der Akten. Um das zu fördern, wurden Leistungserbringer zum 1. Oktober 2025 verpflichtet, bestimmte medizinische Informationen in die ePA einzustellen. Bei Nichtbefüllung können Sanktionen greifen. Die ePA zeigt damit besonders deutlich, dass technische Verfügbarkeit allein nicht ausreicht, sondern organisatorische und prozessuale Voraussetzungen entscheidend sind.

Die Ergebnisse des E-Health Monitor 2025 zeigen klar, dass die Nutzung von TI-Anwendungen insgesamt zunimmt, jedoch sehr unterschiedlich ausgeprägt ist. Anwendungen mit klaren, transaktionalen Prozessen wie das E-Rezept erreichen schnell hohe Akzeptanz. Komplexere Anwendungen wie die elektronische Patientenakte benötigen hingegen deutlich mehr Zeit, Integration und organisatorische Anpassung. Besonders spannend bleibt, wie sich die Nutzung der ePA in dem kommenden Jahr entwickelt und ob es gelingt, aus formaler Abdeckung tatsächlichen digitalen Mehrwert zu schaffen.

Die Digitalisierung des deutschen Gesundheitswesens hat 2025 einen Punkt erreicht, an dem Fortschritt und Ernüchterung gleichzeitig sichtbar werden. Mit der verpflichtenden Einführung zentraler Anwendungen wie E-Rezept und elektronischer Patientenakte, einer nahezu flächendeckenden Anbindung an die Telematikinfrastruktur sowie den gesetzlichen Rahmenbedingungen wie dem Digitalgesetz (DigiG), dem Gesundheitsdatennutzungsgesetz (GDNG) und dem Gesundheitsdigitalagenturgesetz (GDAG) sind die Voraussetzungen für digitale Versorgung so umfassend wie nie zuvor. Der E-Health Monitor 2025 zeigt jedoch, dass diese Infrastruktur im Versorgungsalltag bislang nur begrenzt Wirkung entfaltet.

Diese Diskrepanz ist kein kurzfristiges Umsetzungsproblem, sondern Ausdruck eines strukturellen Spannungsfeldes. Die TI wurde über Jahre primär als verpflichtende Infrastruktur etabliert, mit starkem Fokus auf Sicherheit, Regulierung und formaler Anbindung. Die Frage, wie digitale Anwendungen tatsächlich in bestehende Arbeitsabläufe integriert werden können, spielte in der frühen Phase eine untergeordnete Rolle. Entsprechend erleben viele Leistungserbringer die TI weniger als Entlastung, sondern als zusätzliche Ebene, die neben den bestehenden Prozessen betrieben werden muss.

Die Telematikinfrastruktur lässt sich als zentrales Rückgrat für digitale Kommunikation, Authentifizierung und den sicheren Austausch medizinischer Daten im Gesundheitswesen beschreiben. Technisch umfasst sie eine Vielzahl von Komponenten und Diensten von Identitätsmanagement über Kommunikationsdienste wie KIM bis hin zu Anwendungen wie ePA und E-Rezept. Die TI ist hochgradig sicherheitsorientiert und regulatorisch eng geführt. Gleichzeitig erhöht sie die technische und organisatorische Komplexität für die angeschlossenen Einrichtungen erheblich, insbesondere dort, wo neue Anwendungen tief in bestehende Systeme integriert werden müssen.

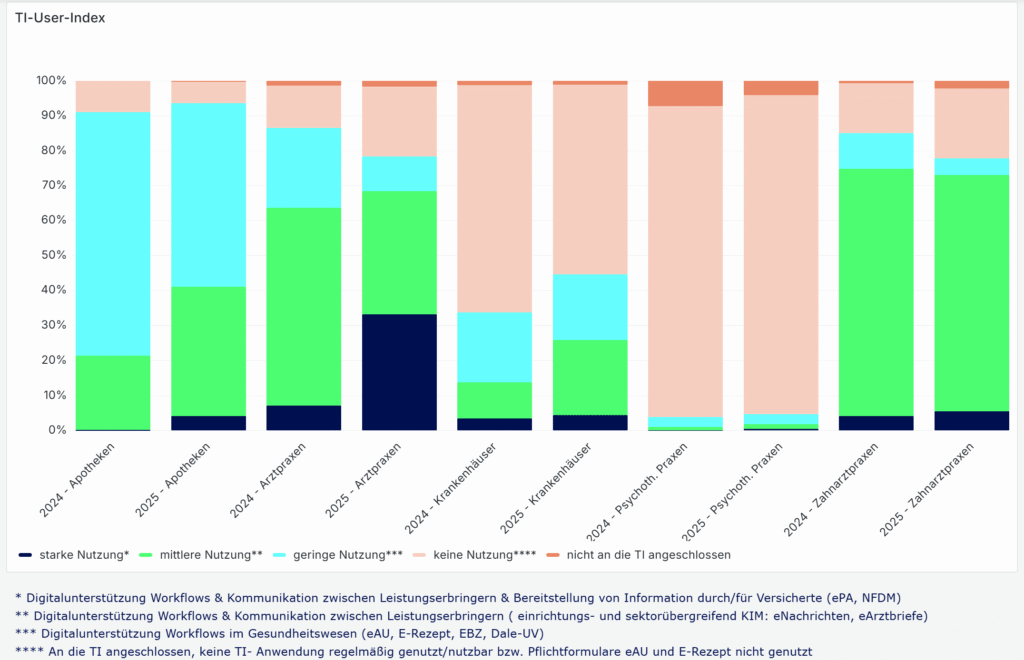

Ein zentrales Ergebnis aus den ersten Kapiteln des E-Health Monitors ist, dass die digitale Reife im Gesundheitswesen ziemlich unterschiedlich ausfällt. Der häufig pauschal beschriebene „Stand der Digitalisierung“ verdeckt erhebliche Unterschiede zwischen den Leistungserbringern. Während 64 Prozent der Praxen TI-Anwendungen zumindest regelmäßig bis intensiv nutzen, ist die Nutzungsintensität mit nur 13 Prozent der Krankenhäuser deutlich geringer. Zwar sind Krankenhäuser vollständig angebunden, doch der Anteil der Krankenhäuser, die die TI mittel bis intensiv im Alltag einsetzen, liegt deutlich unter dem ambulanten Niveau. Der TI-User-Index der gematik verdeutlicht diese Unterschiede zusätzlich: Während sich bei Arztpraxen 2025 ein deutlicher Anteil mittlerer und starker Nutzung der TI-Anwendungen zeigt, dominiert bei Krankenhäusern weiterhin der Bereich „keine Nutzung“. Selbst im Jahresvergleich 2024 zu 2025 bleibt der Anteil der TI aktiv nutzenden Kliniken gering, während Praxen ihre Nutzungsintensität sichtbar steigern konnten. Ein Befund, der vor allem die höhere strukturelle und organisatorische Komplexität des stationären Bereichs widerspiegelt.

Diese Unterschiede sind strukturell erklärbar. Ambulante Praxen arbeiten häufig mit vergleichsweise homogenen IT-Systemen und klar abgegrenzten Workflows, in die einzelne TI-Anwendungen punktuell integriert werden können. Krankenhäuser hingegen verfügen über hochkomplexe, historisch gewachsene IT-Landschaften mit zahlreichen Subsystemen, Schnittstellen und Abhängigkeiten. Neue digitale Anwendungen greifen hier in bestehende KIS-Strukturen ein, was Implementierungen zeitintensiv macht und stark von Herstellern abhängig ist. Digitale Prozesse lassen sich dadurch deutlich schwerer standardisieren und skalieren.

Hinzu kommt, dass technische Instabilitäten der TI keine Seltenheit sind. Der E-Health Monitor 2025 zeigt, dass technische Probleme bzw. die Fehleranfälligkeit für Kartenterminals und Konnektoren weiterhin ein relevanter Faktor sind.

Während Ausfälle oder Störungen im ambulanten Bereich häufig zu Mehrarbeit und Umgehungslösungen wie dem Faxgerät führen, können dieselben Probleme im stationären Umfeld ganze Prozessketten betreffen – von der Aufnahme über die Dokumentation bis hin zur Entlassung. Die Sensibilität gegenüber Systemstörungen ist entsprechend höher, was die Akzeptanz digitaler Anwendungen zusätzlich beeinflusst. Vor diesem Hintergrund ist die geringere Nutzungsintensität im stationären Bereich weniger als Defizit zu verstehen, sondern als Ausdruck der erheblich komplexeren Ausgangslage, unter der digitale Transformation im Krankenhaus stattfindet.

Diese Unterschiede spiegeln sich auch in dem TI-Atlas Dashboard der gematik wider. Zwar zeigt der „TI-Readiness-Index“, dass Apotheken, Arztpraxen und Krankenhäuser bis auf maximal 2 Prozent voll an die TI angeschlossen sind, doch der sogenannte TI-User-Index zeigt, dass aktive Nutzung und Integration stark variieren. Der TI-User-Index differenziert dabei zwischen starker, mittlerer, geringer und keiner Nutzung. Besonders auffällig ist, dass selbst bei nahezu vollständiger technischer Anbindung große Teile der Leistungserbringer TI-Anwendungen kaum oder gar nicht im Arbeitsalltag einsetzen.

TI User Index der gematik (Screenshot vom 28.12.25, aufgerufen unter: TI Atlas Dashboard)

Auch in der Nutzung einzelner TI-Anwendungen zeigen sich deutliche Unterschiede. Während E-Rezept und der KIM-Dienst vergleichsweise stark genutzt werden, bleibt die Nutzung der elektronischen Patientenakte weiterhin deutlich hinter den Erwartungen zurück.

Der Stand der Telematikinfrastruktur im Jahr 2025 ist damit weniger eine Frage fehlender Technik als fehlender struktureller Passung. Die TI-Infrastruktur ist vorhanden, doch sie ist noch nicht konsequent auf die Realität unterschiedlicher Versorgungsbereiche ausgerichtet. Digitale Reife entsteht nicht nur durch Anschlussquoten oder gesetzliche Verpflichtungen, sondern durch technische Stabilität der TI, reduzierte Komplexität und eine Integration, die sich an realen Arbeitsabläufen orientiert.

Der E-Health Monitor 2025 macht deutlich, dass sich der Schwerpunkt der Digitalisierung auch noch in eine andere Richtung verschieben muss: weg von der Frage, ob digitale Infrastruktur existiert, hin zu der Frage, wie sie genutzt wird und von wem. Erst wenn digitale Anwendungen in ambulanten und stationären Settings gleichermaßen betriebsstabil und praxistauglich integrierbar sind, kann aus technischer Anbindung, digitale Reife und digitale Versorgung werden.

Der aktuelle „Stand der Digitalisierung“ ist damit weniger als Leistungsbewertung einzelner Akteure zu verstehen, sondern als Ausdruck der Komplexität der Aufgabe insgesamt. Die Unterschiede zwischen ambulantem und stationärem Bereich verdeutlichen, dass digitale Transformation im Gesundheitswesen nur dann gelingen kann, wenn Infrastruktur, Prozesse und organisatorische Realität konsequent zusammengedacht werden. Insbesondere dort, wo komplexe klinische Abläufe, hohe Integrationsanforderungen und kritische Versorgungsprozesse aufeinandertreffen

Der Austritt von Mitarbeitenden stellt IT-Abteilungen regelmäßig vor eine sensible Aufgabe. Geschäftskritische Dokumente liegen häufig im persönlichen OneDrive-Konto und müssen rechtzeitig, vollständig und nachvollziehbar an Nachfolger oder Führungskräfte übergeben werden. In der Praxis ist dieser Prozess jedoch oft fehleranfällig: Benachrichtigungen werden übersehen, Dateien werden nur kopiert statt sauber übertragen oder bestehende Freigaben gehen verloren.

Mit dem Microsoft Message Center Update MC1164381 adressiert Microsoft genau diese Herausforderungen und verbessert den Offboarding-Prozess rund um OneDrive spürbar.

Das Update verfolgt ein klares Ziel: Die Übergabe von Dateien ausscheidender Mitarbeitender soll einfacher, transparenter und weniger abhängig von manuellen Einzelschritten sein. Gleichzeitig möchte Microsoft sicherstellen, dass bestehende Zusammenarbeit (insbesondere durch Freigaben) möglichst unterbrechungsfrei fortgesetzt werden kann. Dabei handelt es sich nicht um eine neue Funktion im engeren Sinne, sondern um eine gezielte Weiterentwicklung bestehender Mechanismen, die im Alltag vieler Organisationen bislang nur eingeschränkt zuverlässig funktioniert haben. Der Rollout der Änderungen begann Mitte Oktober 2025 und soll nach aktuellem Stand bis Ende Januar 2026 vollständig abgeschlossen sein. Die Funktionen werden automatisch im Tenant aktiviert; eine gesonderte Konfiguration oder Lizenzanpassung ist nicht erforderlich. Für IT-Abteilungen bedeutet das: Die Neuerungen kommen, unabhängig davon, ob bestehende Prozesse bereits darauf vorbereitet sind.

Eine der zentralen Änderungen betrifft die Benachrichtigungen im Rahmen des sogenannten Account-Cleanup-Prozesses. Wird ein Benutzerkonto gelöscht, delegiert Microsoft den Zugriff auf das zugehörige OneDrive automatisch an den in Entra ID hinterlegten Manager oder an einen definierten sekundären Besitzer. Die entsprechenden E-Mails werden künftig deutlich auffälliger gestaltet. Hintergrund ist eine bekannte Schwachstelle: In vielen Organisationen hängt die gesamte Dateiübergabe faktisch an einer einzelnen E-Mail. Wird diese übersehen, verstreicht die Retentionsfrist, und Daten gehen unwiederbringlich verloren. Durch die verbesserte Sichtbarkeit soll dieses Risiko deutlich reduziert werden.

Zusätzlich verbessert Microsoft die Benutzeroberfläche für Manager und Owner, die Zugriff auf das OneDrive eines ausgeschiedenen Mitarbeiters erhalten. Neue Filteroptionen erleichtern es, gezielt nach freigegebenen oder besonders relevanten Dateien zu suchen. Statt sich durch eine vollständige Ordnerstruktur arbeiten zu müssen, können Verantwortliche schneller erkennen, welche Inhalte tatsächlich in der Zusammenarbeit genutzt wurden. Das spart Zeit und reduziert die Gefahr, wichtige Dateien zu übersehen.

Eine besonders praxisrelevante Neuerung ist die erweiterte Möglichkeit, mehrere Dateien gesammelt zu verschieben und dabei bestehende Freigaben beizubehalten. Microsoft beschreibt diesen Vorgang ausdrücklich als echtes „Verschieben“ und nicht als Kopieren.

Auch die Kommunikation an bestehende Kollaborierende wurde überarbeitet. Werden mehrere Dateien gleichzeitig verschoben, erhalten die betroffenen Nutzer künftig eine zusammengefasste Benachrichtigung anstelle vieler einzelner E-Mails. Das reduziert nicht nur die E-Mail-Flut, sondern erhöht auch die Akzeptanz solcher Übergabeprozesse im Fachbereich. Änderungen an Dateiablagen werden transparenter wahrgenommen, ohne als störend empfunden zu werden.

Der grundsätzliche Ablauf nach dem Löschen eines Benutzerkontos bleibt bestehen, wird jedoch klarer kommuniziert. Nach der automatischen Zugriffserteilung informiert Microsoft über die geltende OneDrive-Retention. Zusätzlich erfolgt sieben Tage vor Ablauf eine Erinnerung, dass das OneDrive bald gelöscht wird. In vielen Tenants beträgt diese Frist standardmäßig 30 Tage, kann jedoch über Richtlinien angepasst werden. Entscheidend ist dabei weniger die Frist selbst, sondern die organisatorische Vorbereitung: Ist ein Manager im Benutzerprofil gepflegt? Gibt es einen sekundären Owner als Fallback? Ohne diese Zuordnungen kann auch der verbesserte Prozess seine Wirkung nicht entfalten.

MC1164381 ist kein spektakuläres Feature-Release, aber ein sehr praxisnahes Update. Microsoft greift typische Probleme aus dem Offboarding-Alltag auf und reduziert den manuellen Aufwand für IT, Führungskräfte und Fachbereiche spürbar. Für Sie als Organisation ist dies ein guter Anlass, bestehende Offboarding-Prozesse zu überprüfen. Sind Verantwortlichkeiten klar definiert? Werden Benutzerprofile sauber gepflegt? Und liegen geschäftskritische Inhalte überhaupt am richtigen Ort? Wenn diese Grundlagen stimmen, entfaltet das Update seinen vollen Nutzen und trägt dazu bei, Datenverluste, operative Hektik und unnötige Nacharbeiten beim Mitarbeiteraustritt deutlich zu reduzieren.

Bei Fragen oder Anregungen zum Thema New Work, zur Microsoft Welt oder zu Collaboration Tools stehen wir Ihnen gerne beratend zur Seite. Wir freuen uns auf Ihre Kontaktaufnahme. Weitere Blogartikel aus Bereichen, die von New Work, über Microsoft 365 bis hin zu Sustainable IT reichen, finden Sie auf unserer Blogseite.

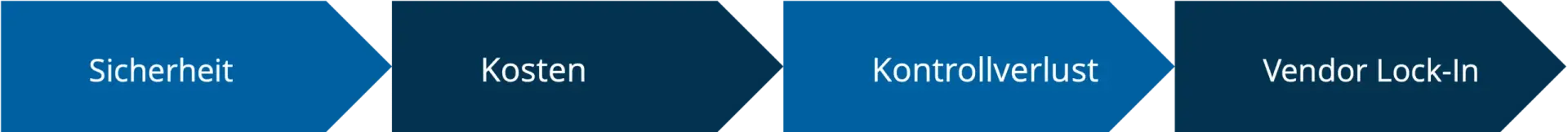

Die Cloud-Transformation verspricht Flexibilität, Skalierbarkeit und Kosteneffizienz. Bei der Migration ihrer IT-Infrastruktur in die Cloud zögern trotzdem nach wie vor viele Unternehmen. Sie haben Sicherheitsbedenken, befürchten Kontrollverluste und haben Angst vor unkalkulierbaren Kosten. Hier stellt sich allerdings die Frage: Sind diese Einwände noch berechtigt oder gibt es inzwischen für alle Cloud-Herausforderungen Lösungen? Wir thematisieren heute die häufigsten Bedenken rund um die Cloud und zeigen, wie vermeintliche Nachteile in der Cloud überwunden oder sogar in Vorteile umgewandelt werden können.

Ob in der Führungsebene oder in einzelnen Teams: Skepsis gegenüber der Cloud gibt es immer wieder. Die Einwände sind dabei in der Regel begründet und basieren auf realen Problemen und Herausforderungen. Besonders häufig nennen Unternehmen hier Sicherheitsrisiken, unübersichtliche Kosten, den Verlust direkter Kontrolle über die IT-Infrastruktur und die Abhängigkeit von einzelnen Anbietern. Wir erklären, was es mit diesen Nachteilen in der Cloud auf sich hat und wie Unternehmen sie adressieren können.

Die Sorge um Datensicherheit und Datenschutz steht oft an erster Stelle. Unternehmen haben Angst vor Cyberangriffen, Datenlecks oder unautorisiertem Zugriff auf sensible Daten. Professionelle Cloud-Anbieter investieren jedoch erheblich mehr in Sicherheitsmaßnahmen als es den meisten Unternehmen überhaupt intern möglich wäre. Moderne Cloud-Plattformen gehen Sicherheitsrisiken durch Verschlüsselung, Multi-Faktor-Authentifizierung, kontinuierliche Sicherheitsupdates und Compliance-Zertifizierungen nach internationalen Standards an.

Tipps für diese Herausforderung:

Die Kostenstruktur von Cloud-Infrastrukturen bereitet Unternehmen ebenfalls Sorgen. Traditionelle IT-Investitionen scheinen kalkulierbar und simpel, Cloud-Abrechnungen hingegen scheinen unübersichtlich und können durch nutzungsabhängige Abrechnungsmodelle zur Kostenfalle werden. Wichtig ist an dieser Stelle vor allem ein durchdachtes Finanzmanagement von Beginn an. Denn ohne Überwachung und Optimierung können Ausgaben tatsächlich schnell und unkontrolliert ansteigen.

Tipps für diese Herausforderung:

Beim Umstieg auf eine Cloud-Infrastruktur steht die IT-Infrastruktur nicht mehr im eigenen Rechenzentrum. Das sorgt für einen gefühlten Kontrollverlust und die Sorge, die Kontrolle über kritische Systeme abzugeben. Cloud-Plattformen stellen ihren Kunden jedoch umfassende Management-Tools, detaillierte Monitoring-Dashboards und APIs zur Automatisierung zur Verfügung, die schlussendlich sogar oft mehr Transparenz und Kontrolle schaffen als klassischen On-Premises-Lösungen.

Tipps für diese Herausforderung:

Die Sorge vor einem Vendor Lock-In ist durchaus begründet. Sind Unternehmen zu stark an einen einzelnen Cloud-Anbieter gebunden, erschwert das den potenziellen Wechsel zu anderen Anbietern und kann dadurch für hohe Kosten sorgen. Souveräne Cloud-Lösungen, die die Unabhängigkeit in verschiedenen Bereichen stärken, sind deshalb heute immer gefragter.

Tipps für diese Herausforderung:

Neben konkreten Einwänden stehen viele Unternehmen vor und während der Cloud-Transformation immer wieder vor Herausforderungen, sowohl technisch als auch organisatorisch. Strategische Planung und strukturiertes Vorgehen während der Transformation sind daher umso wichtiger, um die Vorteile der Cloud zu nutzen. Wir haben einige Tipps für Sie zusammengestellt.

Die technische Migration in die Cloud ist komplex und erfordert deshalb eine umfassende Planung. Legacy-Systeme müssen möglicherweise refaktoriert werden, Datenmigrationen erfordern sorgfältige Vorbereitung und bei der Integration mit bestehenden Systemen spielt die Kompatibilität eine wichtige Rolle. IT-Teams setzen sich mit Themen rund um Netzwerklatenz, Bandbreitenbeschränkungen und die Anpassung an cloud-native Architekturen auseinander und haben die Aufgabe, Sicherheits- und Compliance-Anforderungen in der neuen Umgebung zu gewährleisten. Benötigt wird dafür spezialisiertes Know-how, das viele Unternehmen in einem Cloud-Dienstleister suchen.

Tipps für technische Herausforderungen rund um die Cloud:

Dass die Cloud-Transformation nicht einfach ein einmaliges, technisches Projekt ist, ist längst kein Geheimnis mehr. Für eine erfolgreiche Cloud-Transformation benötigt es einen kulturellen Wandel, indem Mitarbeitende neue Arbeitsweisen erlernen und agiler sowie abteilungsübergreifender zusammenarbeiten. Um möglichen Widerständen frühzeitig zu begegnen, sind Change Management, klare Kommunikation und die Einbindung aller relevanten Mitarbeitenden entscheidend. Außerdem braucht es neue Verantwortlichkeiten für die Cloud-Umgebung und Transformation, sodass Prozesse und Best Practices entwickelt werden können.

Tipps für organisatorische Herausforderungen rund um die Cloud:

Bei den Nachteilen in der Cloud – ob Kontrollverlust, Vendor Lock-In, Sicherheit oder Kosten – handelt es sich letztendlich um Herausforderungen, denen Unternehmen sich während der Cloud-Transformation stellen müssen. Für die verschiedensten Einwände gibt es Lösungen in modernen Cloud-Ansätzen, die allerdings auch umgesetzt und gelebt werden müssen. Wichtig ist dabei vor allem eine durchdachte Planung, die sowohl technische als auch organisatorische Punkte berücksichtigt, ebenso wie eine klare Bewertung, in welchen Bereichen der Einsatz der Cloud sinnvoll ist und wo möglicherweise hybride Lösungen der richtige Weg sind, um sich nicht vollständig von gewohnten On-Premises-Umgebungen abzuwenden.

Rewion begleitet Ihr Unternehmen auf dem Weg in die Cloud. Mit umfassender Expertise in der Cloud-Transformation unterstützen wir Sie von der Strategieentwicklung über die Migration bis zum laufenden Betrieb und sorgen so dafür, dass Sie die Vorteile der Cloud optimal für sich nutzen können.

Die Absicherung von E-Mails gehört zu den wichtigsten Sicherheitsmaßnahmen in jeder Organisation. Angriffe über Phishing, Spoofing oder kompromittierte Accounts gehören nach wie vor zu den größten Bedrohungen für Unternehmen – unabhängig von deren Größe. Ein zentraler Baustein zum Schutz vor solchen Angriffen ist DomainKeys Identified Mail (DKIM). DKIM stellt sicher, dass ausgehende E-Mails kryptografisch signiert werden und der Empfänger prüfen kann, ob die Nachricht tatsächlich von Ihrer Domain stammt und auf dem Transportweg nicht verändert wurde.

Allerdings reicht es nicht aus, DKIM einmalig zu aktivieren. Viele Organisationen richten DKIM ein und lassen die Konfiguration anschließend über Jahre unverändert. Das führt dazu, dass die kryptografischen Schlüssel veralten oder die Schlüssellänge nicht mehr den aktuellen Empfehlungen entspricht. Genau hier kommt die DKIM Key Rotation ins Spiel. Die regelmäßige Rotation sorgt dafür, dass die dahinterliegende Kryptografie robust bleibt, Angriffsflächen minimiert werden und Ihre Domain-Reputation geschützt wird.

Ein häufiger Grund, weshalb Unternehmen sich mit ihrem DKIM-Eintrag auseinandersetzen müssen, ist die zu kurze Schlüssellänge. Ältere DKIM-Konfigurationen verwenden oft noch 1024-Bit-Schlüssel. Diese Länge galt einst als ausreichend, wird heute aber als nicht mehr zeitgemäß betrachtet. Moderne Sicherheitsrichtlinien empfehlen durchgängig 2048-Bit-Schlüssel, da diese kryptografisch deutlich stärker sind und besser gegen mögliche Angriffe schützen. Auch viele E-Mail-Anbieter und Spamfilter bewerten zu kurze DKIM-Schlüssel zunehmend negativ, was letztlich die Zustellbarkeit beeinträchtigen kann. Daher ist es sinnvoll, regelmäßig zu prüfen, welche Schlüssellänge in Ihrer DKIM-Konfiguration hinterlegt ist. Schon die einfache Abfrage eines TXT-Records im DNS zeigt Ihnen, ob Ihr Schlüssel veraltet ist und dringend rotiert werden sollte.

Ansonsten geht es natürlich auch direkt über Powershell. Dazu muss sich zunächst mit Exchange Online verbunden werden und danach über DkimSigningConfig die aktuelle Schlüssellänge für alle Domänen, bei den aktuell DKIM konfiguriert ist, ausgelesen werden.

Get-DkimSigningConfig | Format-Table Identity, Selector1KeySize, Selector2KeySize

Wenn bei Selector1KeySize und Selector2KeySize jeweils anstelle von 2048 noch 1024 steht, sind die Gründe für eine zeitige DKIM Key Rotation noch größer.

Wenn Sie DKIM-Schlüssel in Microsoft 365 rotieren möchten, bietet das Security-Portal einen klar strukturierten Prozess. Sie finden die entsprechenden Einstellungen im Microsoft 365 Defender Portal unter „E-Mail & Kollaboration“ und dann unter den „Bedrohungsrichtlinien“. Dort können Sie unter „E-Mail authentication setting“ die DKIM-Konfigurationen Ihrer Domains verwalten.

Für jede Domain stellt Microsoft zwei Selektoren bereit, typischerweise selector1 und selector2. Über die Funktion zur Rotation generiert Microsoft automatisch einen neuen DKIM-Schlüssel. Allerdings immer nur für einen der beiden Selectoren. Die zweite Rotation muss vier Tage später erfolgen! Dieser Ablauf stellt sicher, dass der alte Schlüssel so lange gültig bleibt, bis der neue ohne Unterbrechung übernommen werden kann. Auf diese Weise wird die Signierung nicht unterbrochen, und die E-Mail-Kommunikation bleibt jederzeit abgesichert. Problematisch es nur, wenn ich gleichzeitig auch die Key-Size ändern möchte, denn das kann ich nur über Powershell machen.

Neben der Änderung der Schlüssellänge ist die Nutzung der Powershell besonders praktisch, wenn Sie mehrere Domains verwalten oder Vorgänge automatisieren möchten. Über den Befehl Connect-ExchangeOnline stellen Sie zunächst die Verbindung her. Nachdem wir bereits, wie zuvor beschrieben, die Keys ausgelesen haben, können wir anschließend mit Rotate-DkimSigningConfig -Identity „Rewion.com“ -KeySize „2048“ („Rewion.com“ hier nur als Beispiel), den ersten DKIM-Schlüssel rotieren lassen und gleichzeitig dessen Schlüssellänge auf 2048-Bit festlegen. Um zu überprüfen, ob die Anpassung der Schlüssellänge erfolgreich war, können Sie erneut Get-DkimSigningConfig | Format-Table Identity, Selector1KeySize, Selector2KeySize verwenden. Auch hier bitte daran denken, dass die zweite Rotation vier Tage später erfolgen muss und der zweite 1024-Bit Wert so lange bestehen bleiben würde, bzw. der zweite 2024-Bit Key weiterhin denselben öffentlichen Schlüssel behält.

Ob der eine Schlüssel erfolgreich rotiert wurde, ist daraufhin öffentlich abfragbar. Dazu gibt es diverse Websites, die es anbieten, den eignen DKIM-Eintrag abzufragen. Beispielsweise können Sie Mxtoolbox.com oder DMARCadvisor.com nutzen.

Die regelmäßige DKIM Key Rotation sorgt also dafür, dass Ihre Organisation langfristig geschützt bleibt. Angesichts der zunehmenden Zahl an Angriffen, die auf schwache oder veraltete Kryptografie abzielen, ist dieses Thema keinesfalls optional. Eine saubere DKIM-Konfiguration stärkt die Vertrauenswürdigkeit Ihrer E-Mails, verbessert die Zustellbarkeit und stellt die Einhaltung moderner Sicherheitsstandards sicher. Es lohnt sich daher, Ihre bestehenden DKIM-Einträge zu überprüfen und – falls notwendig – unverzüglich auf 2048-Bit-Schlüssel umzustellen. Durch die angebotenen Werkzeuge im Security Portal oder in PowerShell lässt sich dieser Prozess effizient und mit überschaubarem Aufwand umsetzen. Wenn Sie möchten, unterstützen wir Sie gerne bei der Umsetzung.

Bei Fragen oder Anregungen zum Thema New Work, zur Microsoft Welt oder zu Collaboration Tools stehen wir Ihnen gerne beratend zur Seite. Wir freuen uns auf Ihre Kontaktaufnahme.

Weitere Blogartikel aus Bereichen, die von New Work, über Microsoft 365 bis hin zu Sustainable IT reichen, finden Sie auf unserer Blogseite. Bleiben Sie des Weiteren auf dem aktuellen Stand und folgen Sie uns auf LinkedIn.

In den letzten Jahren hat Künstliche Intelligenz (KI) enorme Fortschritte gemacht und findet Eingang in immer mehr Lebensbereiche. Allerdings tritt damit ein zentrales Problem zutage: Viele KI-Systeme agieren als undurchsichtige „Black Boxes“. Das bedeutet, dass sie Entscheidungen treffen oder Ergebnisse liefern, ohne dass Menschen nachvollziehen können, wie diese zustande gekommen sind. Die internen Prozesse, die gerade bei komplexen Deep-Learning-Modellen mit Millionen von Parametern kompliziert sind, bleiben verborgen. Auch immer mehr Krankenhäuser setzen Künstliche Intelligenz für verschiedene Zwecke ein, aber diese Intransparenz kann erhebliche Probleme für Medizin, Management und IT in Krankenhäusern bedeuten. Dieses Black-Box-Problem führt zu mehreren schwerwiegenden Konsequenzen:

Neben den ethischen und praktischen Gründen gibt es auch einen starken regulatorischen Druck hin zu erklärbarer KI. Die Europäische Union hat mit dem EU AI Act an einem weltweit ersten umfassenden KI-Gesetzesrahmen gearbeitet. Dieser klassifiziert KI-Systeme nach Risiko und legt strenge Auflagen für sogenannte Hochrisiko-KI fest. Transparenz und Nachvollziehbarkeit sind dabei Kernforderungen. Viele KI-Systeme müssen künftig erklärbare Ergebnisse liefern, umfangreich dokumentiert sein und kontinuierlich auf Risiken überwacht werden. Eine Black-Box-KI gerät hier unmittelbar in Konflikt mit dem AI Act. Denn ein intransparentes System kann die Transparenzpflicht nicht erfüllen, es kann nicht nachweisen, dass es auf qualitativ hochwertigen, nicht diskriminierenden Daten beruht, und es lässt keine effektive Auditierung oder Überwachung zu. Entwickler, die keine Einsicht in die Funktionsweise ihres Modells geben können, würden außerdem gegen die Dokumentationspflichten verstoßen. Die Konsequenz: Solche Black-Box-Modelle wären nicht konform mit dem Gesetz und dürften in Hochrisiko-Bereichen nicht eingesetzt werden! Ein Krankenhaus etwa, das ein KI-Diagnosesystem verwendet, das seine Entscheidungen nicht erklären kann, würde gegen die Vorgaben verstoßen und müsste mit Konsequenzen rechnen.

Um das Black-Box-Problem zu lösen, rückt Explainable AI (XAI), also erklärbare KI, in den Fokus. Darunter versteht man eine Sammlung von Methoden und Prozessen, die darauf abzielen, die Funktionsweise und Entscheidungslogik von KI-Modellen für Menschen verständlich zu machen. Statt undurchsichtiger Algorithmen erhalten Anwender nachvollziehbare Erklärungen dafür, wie ein Ergebnis zustande kam. Das ist nicht nur ein akademisches Nice-to-have, sondern aus mehreren Gründen von hoher praktischer Relevanz:

Explainable AI soll KI-Systeme transparenter, vertrauenswürdiger und verantwortungsvoller machen. Sie ist der Schlüssel, um die Black-Box-Falle zu vermeiden und KI-Entscheidungen verständlich zu machen.

Die XAI-Forschung hat zahlreiche Methoden hervorgebracht, um Blick in die „Black Box“ zu gewähren. Je nach Modelltyp und Anwendungsfall kommen verschiedene Ansätze zum Einsatz. Einige wichtige Techniken sind:

Lokale Surrogatmodelle (LIME): Local Interpretable Model-agnostic Explanations (LIME) ist eine beliebte Technik, um individuelle Vorhersagen zu erklären. LIME erzeugt um die jeweilige Vorhersage herum ein einfaches, interpretierbares Modell (z. B. ein kleines Entscheidungsbaum- oder Linearmodell), das das Verhalten der komplexen KI in diesem lokalen Bereich nachahmt. So kann man vereinfacht sehen, warum das große Modell in genau diesem Fall zu seiner Entscheidung kam.

SHAP-Werte: SHapley Additive exPlanations (SHAP) basieren auf spieltheoretischen Konzepten. Für jedes Merkmal wird ein Beitragswert berechnet, der angibt, wie stark dieses Feature die Vorhersage beeinflusst – positiv oder negativ.

Aufmerksamkeits-Maps: In neuronalen Netzen mit Attention-Mechanismen lässt sich visualisieren, auf welche Eingabeteile das Modell seine Aufmerksamkeit fokussiert hat. Bei Texten können so die Worte hervorgehoben werden, die für die Vorhersage maßgeblich waren. Diese Visualisierungen machen die internen Fokus-Punkte der KI greifbar.

Regel- und Entscheidungsbäume: Einige Methoden versuchen, aus komplexen Modellen Wenn-Dann-Regeln oder Entscheidungsbäume abzuleiten. Entscheidungsbäume sind an sich schon gut interpretierbar. Bei unübersichtlichen Modellen kann man mittels Rule Extraction einen Satz nachvollziehbarer Regeln gewinnen, der das Verhalten des Black-Box-Modells näherungsweise beschreibt.

Kontrafaktische Erklärungen: Ein zunehmend populärer Ansatz sind Counterfactual Explanations. Hierbei wird aufgezeigt, wie eine Entscheidung anders ausfallen würde, wenn bestimmte Eingabedaten geändert würden. Eine kontrafaktische Aussage erklärt, was minimal anders sein müsste, um ein anderes Resultat zu erhalten, was sehr intuitiv verständlich ist.

So vielversprechend Explainable AI ist, in der Praxis gibt es auch Hürden und Zielkonflikte. Die wichtigsten Herausforderungen bei der Entwicklung erklärbarer KI sind:

Genauigkeit vs. Interpretierbarkeit: Häufig besteht ein Trade-off zwischen der Leistungsfähigkeit eines KI-Modells und seiner Erklärbarkeit. Die genauesten Modelle (z. B. tiefe neuronale Netze oder riesige Sprachmodelle) sind oft extrem komplex und schwer zu erklären. Umgekehrt sind einfachere, erklärbare Modelle manchmal weniger präzise.

Komplexität der Erklärungen: Eine Erklärung nützt nur, wenn die Adressatengruppe sie versteht. Technische Details, die für Data Scientists sinnvoll sind, können Endanwender überfordern. XAI muss also die Sprachebene anpassen. Von formalen, mathematischen Erklärungen bis hin zu verständlichen Alltagsmetaphern. Dieses Kommunikationsproblem ist anspruchsvoll, denn die gleiche KI-Ausgabe muss je nach Publikum unterschiedlich erläutert werden, ohne falsch oder trivial zu werden.

Rechenaufwand: Viele Erklärungsverfahren bringen zusätzlichen Overhead mit sich. Beispielsweise erfordert LIME das mehrfache Durchlaufen des Modells mit leicht veränderten Eingaben, SHAP berechnet vielfache Kombinationen von Features. Hier müssen XAI-Methoden noch effizienter werden, um das System nicht auszubremsen.

Angriffe auf Erklärsysteme: Ein oft übersehener Aspekt ist die Sicherheit von XAI-Systemen. Ironischerweise können zusätzliche Informationen, die eine Erklärung liefern, von Angreifern genutzt werden, um das KI-Modell anzugreifen oder zu manipulieren. So wäre es möglich, Erklärungen so zu beeinflussen, dass sie gezielt falsche Sicherheit vermitteln oder die KI zu fehlerhaften Schlussfolgerungen leiten. XAI-Methoden müssen daher selbst robust gegen Manipulation und derartige Eingaben sein.

Explainable AI ist ein entscheidender Schritt, um KI-Systeme vertrauenswürdig, sicher und gesellschaftlich akzeptiert zu gestalten. Erklärbare KI verbindet technologische Innovation mit Transparenz und Verantwortlichkeit. Sie ermöglicht es, dass wir die Vorteile leistungsfähiger KI nutzen können, ohne im Unklaren darüber zu bleiben, wie und warum Entscheidungen getroffen wurden. In Zukunft wird XAI vermutlich noch an Bedeutung gewinnen. Regulierungen wie der EU AI Act machen Erklärbarkeit zur Pflicht für viele Anwendungen. Gleichzeitig erwarten Nutzer und die Gesellschaft zu Recht, dass KI fair und nachvollziehbar handelt. Dadurch erhöhen wir das Vertrauen in Künstliche Intelligenz, erfüllen gesetzliche Auflagen und sorgen dafür, dass KI letztlich dem Menschen rechenschaftspflichtig bleibt. Erklärbare KI ist somit der Schlüssel, um KI vollwertig zu nutzen, ohne dabei die Kontrolle aus der Hand zu geben.

Für Krankenhäuser ist der Weg zur KI neben einer technischen Entscheidung auch ein strategischer Schritt, der weitreichende Konsequenzen für die gesamte Organisation mit sich bringt. Wer heute KI-Systeme einkauft, muss morgen auch deren Entscheidungen vertreten können. Gegenüber Patienten, Mitarbeitenden und Behörden. Mit dem EU AI Act wird deutlich, dass sich Beschaffungsprozesse nicht allein an Funktionen und Preisen orientieren können. Erklärbarkeit, Transparenz und Dokumentation werden zu zentralen Kriterien. Daher ist wichtig, vor der Einführung von KI genau zu prüfen, ob die jeweilige KI-Lösung diese Kriterien erfüllt.

Die Verantwortung endet auch nicht mit der Einführung des Systems. Schulung und Kommunikation werden unabdingbar in der KI-Nutzung. Mitarbeitende müssen nicht nur die Funktionsweise der Systeme verstehen, sondern auch deren Grenzen in der ärztlichen Versorgung, in der Pflege, im Controlling und in der IT kennen. Dabei erhöht eine frühzeitige Einbindung aller beteiligten Berufsgruppen nicht nur die Akzeptanz, sondern schafft auch ein gemeinsames Verständnis für Chancen und Risiken.

Ebenso wichtig ist ein klares Governance-Modell. Kliniken sollten festlegen, wer für die Auswahl, Prüfung, Integration und laufende Überwachung von KI-Systemen zuständig ist.

Letztendlich ist es nicht einfach, KI im Krankenhaus einzuführen und es muss auf einige Aspekte geachtet werden. Wer dabei aber gezielt und strukturiert vorgeht, kann langfristig von den Vorteilen von KI profitieren und seinem Krankenhaus einen deutlichen Mehrwert und Wettbewerbsvorteil verschaffen.

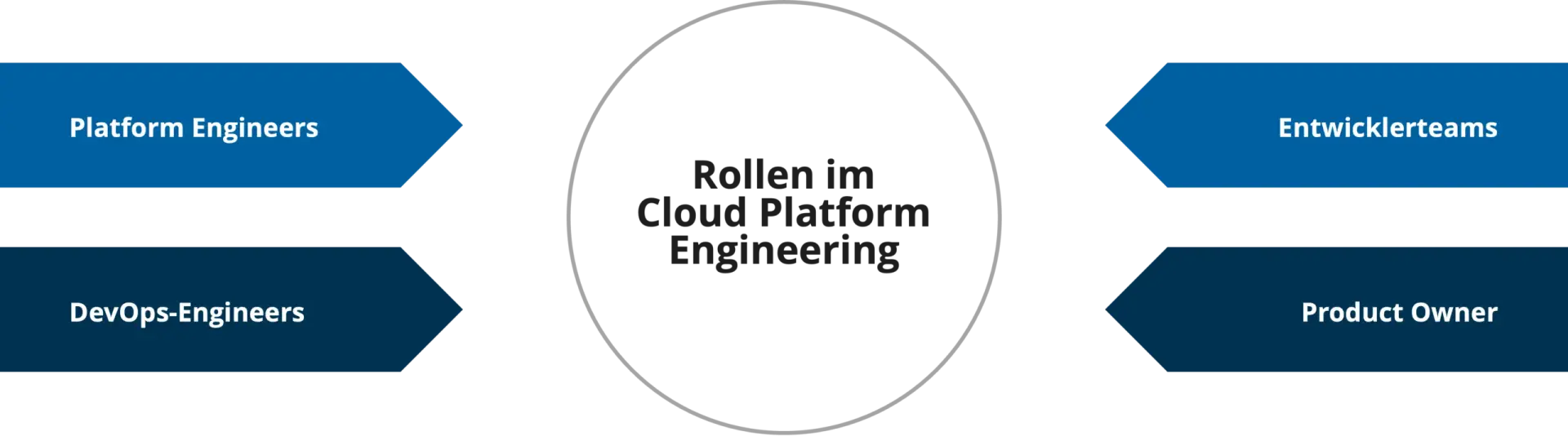

Viele Unternehmen nutzen heute Cloud-Dienste. Oft bedeutet das aber nur, Server bei Amazon, Microsoft oder Google zu mieten, statt im eigenen Rechenzentrum zu betreiben. Cloud Platform Engineering geht einen entscheidenden Schritt weiter: Es verwandelt diese gemieteten Ressourcen in eine maßgeschneiderte, selbstverwaltete Arbeitsumgebung für Teams. In diesem Artikel erklären wir, was genau dahintersteckt, wie Cloud Platform Engineering Teams aussehen und für welche Unternehmen sich dieser Ansatz lohnt.

Bei Cloud Platform Engineering geht es um den systematischen Aufbau und die Verwaltung von Cloud-Infrastrukturen als wiederverwendbare, selbstverwaltete Plattformen. Konkret bedeutet das: Viele Unternehmen setzen Cloud-Dienste einzeln und unabhängig voneinander ein, sodass jeder User sich mit allen Bestandteilen auseinandersetzen, sie verstehen und zusammenbauen muss. Cloud Platform Engineering funktioniert wie eine Art Bausatz-System und verwandelt die komplexen Einzelteile in standardisierte, einfach nutzbare Werkzeuge, die jeder im Team sofort verwenden kann. So wird die Cloud-Infrastruktur als Produkt behandelt, das kontinuierlich verbessert und an die Bedürfnisse der internen Nutzer angepasst wird.

Der Unterschied zur reinen Cloud-Administration ist dabei grundlegend. Cloud-Admins kümmern sich darum, dass Server laufen, Updates installiert werden und alles funktioniert. Cloud Platform Engineering hingegen gestaltet eine komplette Arbeitsumgebung, in der Teams selbstständig agieren können. Dabei verfolgt Platform Engineering drei zentrale Ziele:

Damit Cloud Platform Engineering funktioniert, braucht es klar definierte Aufgaben und Verantwortlichkeiten. Ein Platform Engineering Team besteht dabei aus verschiedenen Rollen:

Die Verantwortlichkeiten sind jedoch klar getrennt: Das Platform Team stellt die Infrastruktur bereit, DevOps optimiert Prozesse und Teams nutzen die Plattform für verschiedene Zwecke. Diese klare Aufgabenteilung schafft Effizienz und ermöglicht es jedem Team, sich auf seine Kernkompetenzen zu konzentrieren. Grundsätzlich geht es darum, eine funktionale Plattform für alle Nutzergruppen zu schaffen: Das kann beispielsweise ein lockeres Zusammenklicken von Services in einer Sandbox-Umgebung sein, aber auch das Enablement von Teams zum compliance-gerechten Deployment eines Workloads.

Cloud Platform Engineering ist kein Muss für jedes Unternehmen. Die Investition in eine umfassende Platform-Strategie lohnt sich vor allem unter bestimmten Kriterien:

Mehrere Nutzergruppen in einem Unternehmen

Unternehmen mit mehreren potenziellen Nutzergruppen profitieren am meisten. Wenn zehn oder mehr Mitarbeitende regelmäßig Cloud-Ressourcen nutzen, zahlt sich die Investition schnell aus. So bastelt nicht mehr jedes Team einzelne Lösungen, sondern alle nutzen dieselbe optimierte Plattform. Die Standardisierung reduziert Reibungsverluste und beschleunigt die Entwicklung über alle Teams hinweg.

Compliance im Mittelpunkt

Organisationen mit hohen Compliance-Anforderungen wie Banken, Versicherungen oder das Gesundheitswesen finden in Platform Engineering einen Verbündeten. Sie müssen nachweisen, dass ihre Systeme bestimmte Sicherheitsstandards erfüllen. Eine gut aufgebaute Plattform stellt automatisch sicher, dass jede Anwendung diese Anforderungen erfüllt, ohne dass Nutzer an unzählige Details denken müssen.

Wachstumsorientierung

Skalierungsorientierte Unternehmen, die schnelles Wachstum erwarten oder erleben, benötigen flexible Infrastrukturen. Wer in kurzer Zeit deutlich mehr Kunden erwartet, kann nicht auf manuelle Prozesse setzen. Cloud Platform Engineering ermöglicht es, neue Märkte schnell zu erschließen und Lastspitzen problemlos zu bewältigen.

Zu Beginn der Cloud-Migration

Unternehmen, die eine Cloud-Migration planen, sollten Platform Engineering von Beginn an berücksichtigen. Statt verschiedene Cloud-Services einzeln zu nutzen, schafft eine durchdachte Plattform-Strategie von Anfang an Struktur und vermeidet späteren Refactoring-Aufwand.

Weniger geeignet ist der Ansatz für sehr kleine Teams, Start-ups in frühen Phasen mit begrenzten Ressourcen oder Projekte mit einfachen Anforderungen, die sich kaum ändern. Hier ist der Aufwand oft größer als der Nutzen.

Cloud Platform Engineering geht weit über traditionelles Cloud Hosting hinaus und entwickelt sich zur wichtigen Grundlage für moderne Cloud-Infrastrukturen in Unternehmen. Statt einfach nur Server zu mieten, schaffen Unternehmen eine maßgeschneiderte Arbeitsumgebung, die Teams in der Anwendung das Leben erleichtert und gleichzeitig Sicherheit, Skalierbarkeit und Effizienz garantiert. Die verschiedenen Rollen arbeiten dabei Hand in Hand: Platform Engineers bauen die Grundlage, DevOps optimiert die Prozesse und Endnutzer können sich auf ihre jeweiligen Stärken konzentrieren. Für Unternehmen mit mehreren Nutzergruppen, hohen Sicherheitsanforderungen oder Wachstumsambitionen ist Cloud Platform Engineering eine strategische Investition, die sich langfristig auszahlt und den entscheidenden Wettbewerbsvorteil bringen kann.

Die Krankenhausreform 2025 markiert einen der größten Umbrüche im deutschen Kliniksektor seit Einführung der DRGs. Sie soll eine „Entökonomisierung“ bewirken und die Qualität der Versorgung erhöhen. Kern des Reformpakets – verankert im Krankenhausversorgungsverbesserungsgesetz (KHVVG) – ist der Übergang weg vom reinen DRG-Fallpauschalensystem hin zu einem hybriden Vergütungssystem mit Vorhaltefinanzierung und Leistungsgruppen. Laut dem Bundesministerium für Gesundheit erhalten notwendige Krankenhäuser künftig eine Art Existenzgrundlage durch Vorhaltepauschalen, sodass auch Kliniken mit weniger Fällen weiterbestehen können. Gleichzeitig werden rund 60–65 Leistungsgruppen (LGs) eingeführt. Das sind klar definierte Bündel medizinischer Leistungen mit bundesweiten Qualitäts- und Strukturkriterien. Bis Ende 2026 müssen die Bundesländer jedem Krankenhaus bestimmte LGs zuteilen, was die zugelassenen Tätigkeitsfelder der Klinik festlegt. Nur Kliniken, die die anspruchsvollen Mindestanforderungen (z.B. Personal, Fallzahlen, Ausstattung) der jeweiligen Leistungsgruppe erfüllen, dürfen diese Leistungen anbieten. Dieses Qualitätsprinzip soll komplexe Behandlungen an spezialisierten Zentren konzentrieren und die Versorgungssicherheit heben, birgt aber die Gefahr, dass kleinere Häuser Leistungen verlieren und sogar schließen müssen, wenn sie Kriterien nicht erfüllen. Insgesamt sollen Qualität und bedarfsgerechte Struktur klar vor Wachstum um jeden Preis stehen. Der ehemalige Gesundheitsminister Lauterbach warnte, ohne Reform müssten sonst bis 2030 ~25% der Kliniken insolvenzbedingt schließen.

Die Reform begreift die digitale Transformation als Herzstück und Motor ihrer Ziele und anders als das KHZG (Krankenhauszukunftsgesetz), das befristete Einzelförderungen für z.B. Patientenportale oder digitale Geräte bot, fordert das KHVVG nun ganzheitliche Digitalisierungskonzepte als Voraussetzung für Fördermittel. Krankenhäuser müssen ihre IT-Infrastruktur modernisieren und interoperabel ausrichten, um Effizienzsteigerung, bessere Vernetzung und Entlastung des Personals zu erreichen. Künftig verlangt die sektorenübergreifende Versorgung einen reibungslosen Datenaustausch zwischen Kliniken und Ambulanten z.B. via elektronischer Patientenakte (ePA), Telemedizin-Plattformen und Cloud-Lösungen. Eine leistungsfähige IT-Infrastruktur ist dafür das Fundament und Insellösungen müssen abgebaut werden. Entsprechend sind umfassende Investitionen in Netzwerke, Hardware und Software unumgänglich. Cloud-Services und SaaS gewinnen an Bedeutung, da sie standortübergreifende Kollaboration erleichtern und skalierbar sowie sicher betrieben werden können.

Außerdem steigen mit der Vernetzung die Anforderungen an die Cybersicherheit erheblich, da Vorgaben aus IT-Sicherheitsgesetz, DSGVO und NIS2 eingehalten werden müssen. Ausfälle durch Cyberangriffe können im schlimmsten Fall sogar lebensbedrohlich für Patienten sein, weshalb IT-Security in Kliniken immer wichtiger wird. Kurz: Die Reform zwingt Kliniken, digitale Schwachstellen proaktiv anzugehen. IT-Leitungen sind gefordert, Resilienz-Checks durchzuführen und Strategien zu entwickeln, wie sie Förderprogramme gezielt nutzen, um Lücken zu schließen. Digitalprojekte müssen in ein holistisches Digitalisierungskonzept eingebettet werden. Das betrifft auch die Personalentwicklung, denn Mitarbeiter brauchen Schulungen im Umgang mit neuen Systemen, damit die Akzeptanz steigt und digitale Tools im Alltag wirklich genutzt werden.

Die ~60 Leistungsgruppen (z.B. Allgemeine Innere Medizin, Geburtshilfe, Herzchirurgie etc.) bringen ein völlig neues Planungsinstrument in die Krankenhauslandschaft. Sie ersetzen die bisherigen Fachabteilungsbegriffe durch bundesweit einheitliche Kategorien mit klaren Qualitätskriterien und Mindestmengen. Ein vom BMG eingesetzter Leistungsgruppen-Ausschuss erarbeitet laufend Empfehlungen zu diesen Kriterien. Die Länder müssen jedem Krankenhaus genau definieren, für welche Leistungsgruppen es autorisiert ist. In der Praxis erfordert das von jedem Haus eine kritische Portfolio-Analyse: Wo erfüllen wir die Voraussetzungen (z.B. genügend Fachpersonal, 24/7-Bereitschaften, Mindestfallzahlen) und wo nicht? Viele Krankenhäuser müssen ihr Leistungsspektrum anpassen, ggf. freiwillig auf bestimmte Leistungen verzichten oder Kooperationen eingehen, um Qualitätsvorgaben zu erfüllen. Solche Entscheidungen zwingen Häuser dazu, entsprechende Abteilungen zu schließen oder Patienten in andere Kliniken zu verweisen.

Im Gegenzug sollen spezialisierte Zentren gestärkt werden, indem komplexe Eingriffe dort gebündelt bessere Ergebnisse erzielen. Das erfordert allerdings ein fein abgestimmtes regionales Netzwerk, damit Patienten trotzdem wohnortnah versorgt werden. Die Reform fördert deshalb neue sektorenübergreifende Versorgungszentren (SüV), in denen z.B. ein Grundversorger Krankenhaus zusätzlich ambulante OPs, Kurzzeit- und Übergangspflege anbietet. Solche Umwandlungen entscheiden die Bundesländer. Sie können Kliniken zu Hybridstrukturen weiterentwickeln, um die Basisversorgung vor Ort zu sichern. Dieser Aspekt kommt vor allem ländlichen Regionen zugute, wo viele kleine Häuser existieren.

Mit der Reform steigt der bürokratische Aufwand in puncto Datenlieferungen deutlich, denn Krankenhäuser müssen künftig noch mehr Daten erfassen und melden, oft ohne erkennbaren Nutzen im Klinikalltag, wie der Geschäftsbereichsleiter Digitalisierung & eHealth der DKG kritisiert. So wurde z.B. entschieden, für den neuen Bundes-Klinik-Atlas quartalsweise zusätzliche Leistungs- und Qualitätsdaten jedes Krankenhauses an das InEK zu übermitteln. Dieser “Krankenhausatlas” (online seit Mai 2024) veröffentlicht für Patienten verständlich, welche Klinik welche Leistungen in welcher Qualität anbietet, inklusive Indikatoren wie personelle Ausstattung. Zwar stärkt das die Transparenz für die Öffentlichkeit, bedeutet für die IT-Abteilungen aber, neue Datenströme aufzusetzen und Datensätze aufzubereiten. Viele Infos (z.B. Zuordnung von Personal zu Fachabteilung je Standort, Zuordnung von Personal zu Leistungsgruppen) müssen außerdem Quartalsweise ans InEK übermittelt werden, was Krankenhäuser zum Teil vor erhebliche Herausforderungen stellt. Die Reform hat somit eine paradoxe Doppelwirkung: Einerseits will sie Bürokratie abbauen, andererseits entstehen neue Bürokratiepflichten im Datenmanagement. Markus Holzbrecher-Morys von der DKG bemängelt, es sei versäumt worden zu schauen, wo Digitalisierung wirklich entlasten könnte, statt immer neue Meldewege aufzubauen. Für die Kliniken bedeutet das, dass IT- und Controlling-Teams noch enger zusammenarbeiten müssen, um die wachsenden Reporting-Anforderungen (Qualitätsberichte, Personalnachweise pro LG etc.) fristgerecht und korrekt zu bedienen.

Finanziell wird die Reform durch einen Transformationsfonds von beispiellosem Umfang gestützt. Bund und Länder stellen über 10 Jahre insgesamt 50 Mrd. € bereit. Dieser Fonds fördert Reformprojekte in acht Kategorien (sog. Fördertatbestände). Dazu zählen z.B. die Konzentration akutstationärer Versorgungskapazitäten, Umstrukturierung zu sektorenübergreifenden Gesundheitszentren, Aufbau telemedizinischer Netzwerke und Telechirurgie, Einrichtung spezialisierter Zentren an Unikliniken für komplexe Erkrankungen, oder integrierte Notfallversorgungsstrukturen. Sogar förderfähig ist die dauerhafte Schließung von Krankenhäusern, inkl. Rückbau- und Personalmaßnahmen, wenn dies regional sinnvoll ist. Ebenso der Ausbau von Pflegeschulen zur Fachkräftesicherung. Wichtig hier ist, dass Fördergelder nur für nachhaltige Transformationsprojekte fließen, nicht für laufende Betriebskosten. Kliniken müssen belastbar darlegen, wie ein Projekt die Versorgungsstrukturen im Sinne der Reform verbessert.

Gleichzeitig setzt die Reform mit der Vorhaltefinanzierung ab 2026 auf eine neue Vergütungslogik: 40% der Klinikvergütung sollen als Sockelbetrag für vorgehaltene Kapazitäten fließen, unabhängig von Fallzahlen. Innerhalb eines Korridors von ±20% Fallzahländerung bleibt dieser Anteil konstant, was Planbarkeit schaffen soll. Vorteile des Modells sind geringerer ökonomischer Mengendruck und Förderung von Spezialisierung, Nachteile könnten mehr Verwaltungsaufwand und das Risiko einer Leistungsrationierung (falls Fälle die Korridor-Obergrenze überschreiten und unbezahlte Mehrleistungen erbracht werden) sein. Zusätzlich plant die Reform Hybrid-DRGs auszuweiten, um ambulante Fälle zu fördern: Ab 2026 müssen mindestens 1 Mio. Fälle ambulant abgerechnet werden, steigend auf 2 Mio. bis 2030. Dies soll die Ambulantisierung voranbringen, wird aber für Kliniken eine Umstellung bedeuten. Überdies sind ab 2027 weitere 800 Mio. € jährlich für gezielte Förderungen von bestimmten Einrichtungen, bestimmten Fachbereichen, Notfallstufen-Aufstockung und Anpassungen der Landesbasisfallwerte vorgesehen.

Die Reform wird schrittweise Realität und einige Elemente sind bereits in Kraft: Das KHVVG trat am 1.1.2025 in Kraft, ebenso das Krankenhaustransparenzgesetz und die KHTFV (Förder-Verordnung für den Transformationsfonds). Der Leistungsgruppen-Ausschuss arbeitet seit Januar 2025. Seit 1.7.2025 können Förderanträge für Strukturprojekte gestellt werden. Die entscheidende Phase wird aber ab 2026/27 beginnen: Dann greift die Vorhaltefinanzierung (40% Budgetumstellung), die Bundesländer müssen bis Ende 2026 die LG-Zuweisungen abschließen, und ab 2027 gelten neue Finanzierungs- und Notfallregeln. Die Notfallversorgung selbst wird durch ein geplantes Notfallzentren-Gesetz NotfallG neu geordnet (Einführung Integrierter Notfallzentren an Kliniken).

Für Kliniken bedeutet die Krankenhausreform strategische Planung, Antragstellung, Umbau und ggf. Zusammenschlüsse müssen parallel zum laufenden Betrieb gestemmt werden. Bereits jetzt zeigt sich, dass weitere Anpassungen nötig sind, um Praxisprobleme zu lösen. Die neue Bundesgesundheitsministerin Nina Warken spricht davon, an der Reform nachzusteuern, wo es nötig ist. Trotz allem Zeitdruck ist eine sorgfältige Umsetzung entscheidend. Übereilte Schließungen oder unkoordinierte Veränderungen könnten sonst die Versorgung gefährden.

Für große Maximalversorger und Spezialkliniken bietet die Reform erhebliche Chancen. Sie können ihre Rolle als Zentren ausbauen, von der Konzentration komplexer Fälle profitieren und über den Transformationsfonds großzügige Mittel erhalten. Durch Kooperationen mit umliegenden Häusern können sie zum Anker regionaler Netzwerke werden. Allerdings stehen auch sie vor Herausforderungen: Die neuen Qualitätsvorgaben erfordern mehr Fachpersonal und Investitionen in Prozesse, was in Zeiten des Fachkräftemangels nicht trivial ist. Zudem erhöht die Transparenz (z.B. Vergleichsportale) den Wettbewerb um Patienten und Personal.

Mittelgroße Krankenhäuser müssen strategisch klug navigieren. Viele werden sich spezialisieren oder Leistungsportfolio reduzieren müssen, um die Anforderungen ihrer Kern-LGs zu erfüllen. Sie könnten vermehrt Schwerpunkte bilden (etwa ein Haus fokussiert sich auf Orthopädie, ein anderes Kardiologie in der Region). Kooperationen und Verbünde werden für diese Häuser essenziell – gemeinsam lässt sich etwa ein 24/7-Bereitschaftsdienst eher absichern als allein. Das stellt neue Anforderungen an IT (Verbundsysteme, gemeinsame Telekonsile etc.) und Governance. Ein Risiko ist, dass mittlere Häuser im Übergang Einnahmen verlieren, wenn bestimmte lukrative Leistungen wegfallen.

Kleine Grund- und Regelversorger in ländlichen Gebieten sollen durch die Reform eigentlich geschützt werden (Stichwort flächendeckende Versorgung). Sie erhalten über Vorhaltebudgets eine Grundfinanzierung, auch wenn Fallzahlen sinken. Zudem können sie sich zu Gesundheitszentren wandeln, die etwa Notfallversorgung, interne Medizin und ambulante Angebote bündeln. Doch es bleiben Risiken. Wenn die Vorhaltefinanzierung keine zusätzlichen Gelder bringt, könnten auch kleine Häuser finanziell weiter unter Druck stehen. Müssen sie Leistungen wie Geburtshilfe oder Chirurgie aufgeben, weil sie die Kriterien nicht erfüllen, könnte das Image leiden und Patienten abwandern. Offene Fragen sind, wie die Bevölkerung solche Veränderungen annimmt. Schließt „das kleine Krankenhaus nebenan“, kann das zunächst Widerstand erzeugen. Außerdem muss politisch begleitet werden, dass Notfall- und Grundversorgung überall erreichbar bleiben. Auch steht zur Diskussion, wie Haftung und Verantwortung verteilt werden, wenn mehrere Häuser im Verbund Versorgung leisten. Hier könnten neue Modelle nötig sein.

Die Krankenhausreform 2025 bringt für Klinik-Entscheider eine Fülle strategischer Implikationen. Sie erzwingt Modernisierung insbesondere in Digitalisierung und IT, die als Enabler für Vernetzung, Qualitätstransparenz und Effizienz dienen. Sie eröffnet Chancen auf Fördermittel in nie dagewesener Höhe, verlangt aber vorausschauende Planung und Kooperation. Gerade hier muss identifiziert werden, wo aktuelle Schwachstellen liegen und wie der Fonds für das eigene Haus genutzt werden kann. Gleichzeitig erhöht sie den Regulierungsdruck, denn starre Qualitätsvorgaben und Meldepflichten fordern den Einrichtungen organisatorisch viel ab. Große Häuser können gestärkt hervorgehen, während kleinere kreativ ihre Rolle neu definieren müssen, um im neuen System zu bestehen. Erfolgreich wird die Reform aus Sicht der Krankenhäuser nur sein, wenn neben Struktur und Qualität auch die Finanzierung nachhaltig gesichert wird und digitale Innovation tatsächlich Bürokratie abbaut statt erzeugt.

Ein turbulentes Jahr im Hinblick auf den Datenschutz und Microsoft geht bald zu Ende. Während sich verändernde, geopolitische Entwicklungen auch vor Auswirkungen auf Microsoft 365 (M365) keinen Halt gemacht haben, gibt es positive Neuigkeiten aus Hessen. Hier hat zuletzt die Aufsichtsbehörde in einer Veröffentlichung festgestellt, dass Microsoft 365 datenschutzkonform einsetzbar ist. Grund genug für uns, die unterschiedlichen Entwicklungen des Jahres für Sie zusammenzufassen und aufzubereiten.

Getrieben unter anderem durch Fälle wie dem von Microsoft Produkten ausgesperrten Chefanklägers des Internationalen Gerichtshof, kamen bereits Anfang des Jahres Diskussionen über die Souveränität von Microsoft als US-amerikanisches Unternehmen auf. Der Aufschrei war groß. Zu den diskutierten Themen rund um Cloud-Anbieter aus den USA kam damit ein weiteres hinzu. Und damit nicht genug.

Der Chefjustitiar von Microsoft France wurde vor den französischen Senat gebeten und befragt. Unter anderem wurde ihm sinngemäß unter Eid die Frage gestellt, ob Microsoft ausschließen könne, dass „niemals auf Anordnung der US-Regierung ohne die ausdrückliche Zustimmung der französischen Behörden weitergegeben werden“. Dies konnte er nicht garantieren, wies aber gleichsam daraufhin, dass es noch nie vorgekommen sei. Zusätzlich gab er über den Eskalationsprozess Auskunft und erwähnte, dass eine Beantwortung nur das letzte Mittel sei.

Die nächsten Diskussionen, auch in Deutschland, begannen. Wie sehr kann Microsoft den Schutz der (personenbezogenen) Daten vor staatlichen Institutionen in den USA garantieren?

Und dann war da noch das laufende Verfahren des Europäischen Datenschutzbeauftragten (EDSB) zum Einsatz von M365 in der EU-Kommission. Seinerzeit hauptsächlich initiiert aufgrund der unvollständigen Dokumentation von Verarbeitungen im Zusammenhang mit der Nutzung, wurde ebenso der Transfer von Daten ins Drittland bemängelt.

Zur Mitte dieses Jahres wurde das Verfahren jedoch offiziell eingestellt – mit positivem Ausgang. Der EDSB würdigte die Abhilfemaßnahmen, insbesondere auch in der Zusammenarbeit mit Microsoft. Folglich hat er festgestellt, dass ein datenschutzkonformer Einsatz möglich ist.

Mitten in die Debatten um Datenschutz und Souveränität platzierte Microsoft drei neue Angebote: die Sovereign Public Cloud, Sovereign Private Cloud und National Partners. Auch wir berichteten bereits auf unserem Blog über Einzelheiten rund um dieses Angebot: Die Microsoft Sovereign Cloud im Überblick. Damit reiht sich Microsoft in einen Trend von mehreren US-Anbietern ein. Auch andere Hyperscaler, wie z.B. Google in einer Partnerschaft mit Stackit, erweiterten ihr Angebot für europäische Kunden rund um souveräne Varianten ihrer Lösungen, oftmals betrieben auf europäischer Infrastruktur.

Nun folgte eine weitere positive Meldung zum Jahresende. In Hessen untersuchte die Landesdatenschutzbehörde den Einsatz von M365 und legte einen Abschlussbericht vor. In diesem kam die Behörde zur Erkenntnis, dass die ursprünglich im Rahmen der Datenschutzkonferenz (DSK) aus dem Jahr 2022 kritisierten Punkte so nicht mehr zutreffen würden oder aber mittlerweile von Microsoft nachgebessert worden seien. Dies betraf hauptsächlich die Kritik am „Data Protection Addendum“ (DPA) und seinen Weisungsbefugnissen für den Verantwortlichen, Dokumentationen rund um Datenverarbeitungen in M365 und wiederum den Drittlandtransfer (hier: USA). (Link: HBDI: Microsoft 365 kann datenschutzkonform genutzt werden | datenschutz.hessen.de)

Besonders hervorgehoben wurde das „neue“ Datenschutz-Kit (Link: Neue Datenschutz-Hilfen von Microsoft: M365-Kit, Cloud Compendium und DSFA-Vorlagen für Unternehmen – Source EMEA), das im Service Trust Portal von Microsoft umfangreiche Hilfestellungen für Verantwortliche bei der Erfüllung ihrer Datenschutzpflichten enthält. Zusätzlich enthielte das DPA nunmehr Ergänzungen, die allen voran im öffentlichen Bereich die Rahmenbedingungen eines Einsatzes verbessern würden. Und schlussendlich ist durch die Finalisierung der „EU Data Boundary“, also der Speicherung europäischer Daten in europäischen Rechenzentren und dem Angemessenheitsbeschluss mit den USA, die Dimension des Drittlandtransfers verbessert worden.

Wohlgemerkt sei angemerkt, dass die Behörde ihre Analyse ohne technische Betrachtungen „unter die Haube“ durchgeführt hat. Unterschwellige, technische Datenverarbeitungen (nachzu-)prüfen, war kein Betrachtungsgegenstand.

Es war ein Jahr voller Höhen und Tiefen für Organisationen, die M365 einsetzen. Zur Wahrheit gehört aber auch: War in den vergangenen Jahren die Meinung klar, dass ein datenschutzkonformer Einsatz von M365 per se nicht möglich sei, gab es nun an prominenten Stellen Gegenmeinungen. Zu beachten ist jedoch, dass trotz allen positiven Entwicklungen die eigenen „Hausaufgaben“ für Verantwortliche bleiben. Denn auch die zusätzlichen Dokumentationsvorlagen und Materialien, die Microsoft zur Verfügung stellt, entfalten ihre Wirkung lediglich, wenn Verantwortliche diese für ihren individuellen Einsatz und Rahmenbedingungen bewerten bzw. anpassen.

Mobile Endgeräte wie Laptops, Smartphones und Tablets sind aus dem Unternehmensalltag längst nicht mehr wegzudenken. Sie ermöglichen flexibles Arbeiten, müssen aber auch durchdacht eingesetzt werden. Mobile Device Management macht die zentrale Verwaltung und Absicherung der Geräte möglich. Wie lässt sich eine solche MDM-Lösung aber einführen, ohne dabei den laufenden Alltag zu stören? Schließlich können die Geräte nicht einfach für mehrere Tage oder Wochen außer Betrieb genommen werden. Wir geben einen Überblick über mögliche Wege für die Mobile Device Management Integration in Unternehmen und geben Tipps für die Praxis.

Die Einführung eines Mobile Device Management Systems ist für viele Unternehmen ein Balanceakt: Einerseits müssen mobile Endgeräte zentral erfasst, verwaltet und abgesichert werden, andererseits darf der laufende Geschäftsbetrieb nicht beeinträchtigt werden. Es entstehen also verschiedene Herausforderungen:

Unternehmen haben also die Aufgabe, zuerst umfassend zu planen, schrittweise vorzugehen und vor allem transparent zu kommunizieren, um Mitarbeitende von den Veränderungen zu überzeugen.

Für eine erfolgreiche MDM-Integration sind drei große Schritte nötig: eine gründliche Vorbereitung, die schrittweise Implementierung und die dauerhafte Optimierung. Insbesondere die schrittweise Einführung sorgt dafür, dass die Implementierung nicht zu Schwierigkeiten im Arbeitsalltag führt.

Eine umfassende Vorbereitung ist die Grundlage für die erfolgreiche Einführung einer MDM-Lösung. In dieser Phase werden alle technischen, organisatorischen und kommunikativen Vorbereitungen getroffen, damit die spätere Implementierung reibungslos und nach klarem Plan ablaufen kann.

Für die tatsächliche Integration ist ein kontrolliertes und schrittweises Vorgehen der Weg der Wahl. Insbesondere, wenn es darum geht, den laufenden Betrieb nicht zu stören, sorgt ein durchdachter Prozess für Sicherheit und Akzeptanz.

Nach dem Rollout steht die wichtige Phase der Überwachung und Weiterentwicklung auf dem Plan. Kontinuierliche Evaluation und Anpassung sorgen dafür, dass das MDM-System langfristig funktioniert und akzeptiert wird.

Die Integration von Mobile Device Management im laufenden Betrieb ist zwar komplex, aber mit strukturiertem Vorgehen erfolgreich umsetzbar. Grundlage für eine erfolgreiche Einführung sind eine detaillierte Vorbereitung mit klarer Bestandsaufnahme, schrittweise Implementierung über Pilotphasen bis zum vollständigen Rollout und eine kontinuierliche Erfolgskontrolle und Optimierung. Auch transparente Kommunikation mit den Mitarbeitenden, Support und das Angebot von Schulungen spielen eine wichtige Rolle. Wichtig ist letztendlich, dass MDM im Detail geplant wird, bevor es in die Umsetzung geht. So entsteht am Ende ein stabiler Betrieb mit reduzierten Sicherheitsrisiken und hoher Produktivität, der flexible Arbeit sicher ermöglicht.

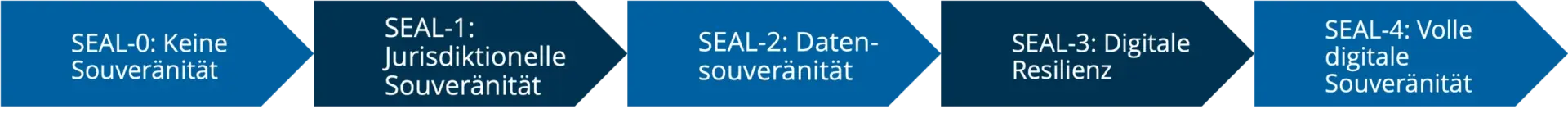

Die Europäische Union stellt die Cloud-Souveränität immer weiter in den Mittelpunkt: In aktuellen Ausschreibungen kommt erstmals ein umfassendes Cloud Sovereignty Framework zum Einsatz, das digitale Souveränität einerseits definiert und sie andererseits messbar macht. Unternehmen können dieses Framework damit als praktischen Leitfaden für ihre eigene Cloud-Strategie einsetzen. Denn die Frage nach Kontrolle, Unabhängigkeit und Rechtssicherheit in der Cloud betrifft längst nicht mehr nur öffentliche Organisationen, sondern alle Unternehmen, die kritische Daten und Workloads in die Cloud verlagern. Erfahren Sie in diesem Artikel, was das Cloud Sovereignty Framework beinhaltet und wie Sie es in der Praxis einsetzen können.

Das von der EU-Kommission entwickelte Cloud Sovereignty Framework basiert auf acht klar definierten Souveränitätszielen. Sie decken verschiedene Aspekte digitaler Unabhängigkeit ab und schaffen so einen ganzheitlichen Rahmen:

Einer der wichtigsten Faktoren des Cloud Sovereignty Frameworks ist die Möglichkeit zur praktischen Anwendung als Bewertungsinstrument in Unternehmen. Die EU nutzt ein zweistufiges Bewertungssystem, das Mindestanforderungen definiert und Differenzierung ermöglicht. Darauf können sich auch Unternehmen in ihrer eigenen Bewertung rund um die souveräne Cloud stützen.

Eine fünfstufige Skala (SEAL-Level: Sovereignty Effectiveness Assurance Levels) von SEAL-0 bis SEAL-4 definiert den Grad der Souveränität.

Ergänzend zum SEAL-Level berechnet die EU einen gewichteten Sovereignty Score. Die Gewichtung ist strategisch durchdacht: Operative Souveränität und Supply Chain Souveränität erhalten jeweils 20 %, da sie die praktische Unabhängigkeit und Resilienz am stärksten beeinflussen. Strategische und Technologie-Souveränität werden mit je 15 % gewichtet. Daten- und KI-, Rechts- und Sicherheitssouveränität erhalten je 10 %, da diese Bereiche bereits durch andere Regularien wie DSGVO, NIS2 oder DORA abgesichert sind. Nachhaltigkeit fließt mit 5 % ein.

Die anschließende Bewertung erfolgt durch offene und geschlossene Fragen an Cloud-Anbieter und wird ergänzt durch Nachweise und öffentliche Dokumentation. Gibt es Schwächen in einzelnen Bereichen, wird der Provider im Gesamtlevel heruntergestuft. Durch diesen Ansatz stellt die EU sicher, dass die Gesamtbewertung nicht durch gute Werte in einzelnen Bereichen beeinflusst werden kann.

Das Cloud Sovereignty Framework ist nicht nur für EU-Ausschreibungen relevant. Vielmehr können auch Unternehmen es als Grundlage für ihre eigene Cloud-Souveränitätsstrategie nutzen. Möglichkeiten zur Anpassung gibt es verschiedene: