Wir begleiten Sie von der ersten Datenanalyse bis zur produktiven Lösung. Gemeinsam identifizieren wir relevante Use Cases, entwickeln tragfähige Analytics-Strategien und setzen Data Science-Projekte um, die Ihre Entscheidungsfindung verbessern.

Erfolgreiche Datennutzung erfordert mehr als Technologie: Wir betrachten Ihre Geschäftsziele, bestehende Prozesse und die Anforderungen Ihrer Teams gleichermaßen. So schaffen wir nachhaltige Lösungen, die messbare Ergebnisse liefern.

Schaffen Sie die Grundlage für datenbasierte Entscheidungen durch professionelle Datenbereinigung und -aufbereitung. Wir analysieren Ihre Datenbestände, beseitigen Inkonsistenzen und etablieren nachhaltige Prozesse für eine dauerhaft hohe Datenqualität.

Entwickeln Sie eine zukunftsfähige Datenstrategie, die Mehrwerte in den Fokus stellt und regulatorische Anforderungen erfüllt. Wir definieren klare Data Governance-Strukturen, Verantwortlichkeiten und Prozesse für den sicheren und effizienten Umgang mit Ihren Daten.

Transformieren Sie Ihre Rohdaten in wertvolle Erkenntnisse durch moderne Analytics-Lösungen. Wir konzipieren und implementieren skalierbare Analytics-Plattformen, die Ihnen aussagekräftige Dashboards, Reports und datengetriebene Entscheidungsgrundlagen liefern.

Treffen Sie bessere Entscheidungen durch vorausschauende Analysen und datenbasierte Prognosen. Wir entwickeln Predictive Analytics-Lösungen, die Muster erkennen, Trends vorhersagen und Ihrem Business einen Wettbewerbsvorteil durch proaktives Handeln verschaffen.

Verstehen Sie Ihre Kunden besser und optimieren Sie Ihre Marketingaktivitäten durch datengetriebene Insights. Wir implementieren Analytics-Lösungen für Customer Journey Analysen, Segmentierung und ROI-Messungen, die Ihre Marketing- und Vertriebseffizienz nachhaltig steigern.

There are no results matching your search

Data Science umfasst die Extraktion von Erkenntnissen und Wissen aus Daten durch wissenschaftliche Methoden, Algorithmen und Systeme. Dazu gehören Datensammlung und -aufbereitung, explorative Datenanalyse, statistische Modellierung, Machine Learning und Predictive Analytics sowie Datenvisualisierung. Data Science verbindet Mathematik, Statistik, Informatik und Domänenwissen. Data Scientists entwickeln Modelle zur Vorhersage, Optimierung und Automatisierung, um rohe Daten in handlungsrelevante Insights für datengetriebene Entscheidungen zu transformieren. Es ist Grundlage für KI-Anwendungen, Business Intelligence und digitale Innovation in verschiedensten Branchen.

Eine Data Science Beratung ist sinnvoll, wenn Sie datengetriebene Entscheidungen treffen, Geschäftsprozesse optimieren oder neue Insights aus Daten generieren möchten. Bei großen Datenmengen ohne klare Analysestrategie, fehlendem internem Data Science Know-how oder komplexen Fragestellungen unterstützen Experten. Rewion hilft beispielsweise bei der Entwicklung von Predictive Models, Kundenanalysen, Fraud Detection oder Demand Forecasting. Wenn Sie Machine Learning implementieren, Datenstrategien entwickeln oder Data Science Teams aufbauen möchten, bietet externe Expertise Mehrwert. Bei gescheiterten Analytics-Projekten identifizieren Berater Ursachen. Auch für Quick Wins, Proof-of-Concepts oder Skalierung bestehender Lösungen ist eine externe Beratung wertvoll.

Data Science optimiert Geschäftsprozesse durch datenbasierte Analysen und Vorhersagemodelle. Experten identifizieren Ineffizienzen durch Process Mining und Datenanalyse, entwickeln Predictive Models zur Bedarfsvorhersage und Ressourcenoptimierung sowie Algorithmen für automatisierte Entscheidungen. Anomalie-Erkennung identifiziert Qualitätsprobleme frühzeitig, Customer Analytics verbessern beispielsweise Segmentierung und Personalisierung, Supply Chain Optimization kann Lagerkosten reduzieren. Durch eine Kombination aus Domänenwissen und Data Science entstehen konkrete Handlungsempfehlungen, die die Effizienz steigern, Kosten senken und Qualität verbessern. So wird aus Daten messbarer Geschäftswert generiert.

Rewion bietet umfassende Data Science Services: Wir unterstützen Sie in der Entwicklung von Data Science Strategien und Roadmaps, der Datenanalyse und bei explorativen Analysen zur Insight-Generierung sowie bei Predictive Analytics für Vorhersagen und Forecasting. Außerdem begleiten wir Sie auf dem Weg zu einer zukunftsfähigen Datenstrategie und helfen Ihnen, Ihre Kunden durch Customer & Marketing Analytics besser zu verstehen. Wir unterstützen bei Data Governance, Datenqualitätsmanagement sowie beim Aufbau von Data Science Teams. Von Proof-of-Concepts bis zu produktiven Lösungen begleiten wir alle Phasen.

Rewion zeichnet sich durch eine Kombination aus technischer Data Science Expertise und Geschäftsverständnis aus. Wir übersetzen Business-Fragen in analytische Lösungen und Insights in Handlungen. Als herstellerunabhängiger Partner wählen wir die optimale Technologie für Ihre Anforderungen. Mit Expertise in Machine Learning, Deep Learning, NLP und Big Data entwickeln wir State-of-the-Art-Lösungen und kombinieren Data Science mit Domänenwissen aus verschiedenen Branchen. So schaffen wir datengetriebene Lösungen, die echten Business Value liefern und Wettbewerbsvorteile ermöglichen.

Aktuell gibt es keine Inhalte

Digitale Souveränität ist in zahlreichen Unternehmen in den Fokus gerückt. Ob Cloud, KI oder Datensicherheit: Für Expert:innen entstehen konkrete technische und regulatorische Herausforderungen, die verschiedenste Fragen aufwerfen. Wie können wir Cloud-Infrastrukturen gestalten, die Unabhängigkeit und Performance verbinden? Welche Governance-Modelle brauchen wir, um KI-Systeme unter verschärften Compliance-Anforderungen zu betreiben? Wie können wir Datenschutz und Verfügbarkeit in einem unsicheren geopolitischen Umfeld gewährleisten?

Unser Networking-Event „Digitale Souveränität: Cloud, KI & Datensicherheit im Fokus“ bringt Spezialist:innen aus den Bereichen Cloud Computing, Artificial Intelligence und Cyber sowie Data Security zusammen und möchte den Raum für Austausch öffnen. Wir analysieren technische Architekturansätze, diskutieren Best Practices und kommen so in Vorträgen, Diskussionen und beim abendlichen BBQ über den Dächern Stuttgarts ins Gespräch.

Donnerstag, 7. Mai 2026, 16:00 Uhr

Skyloft Stuttgart

Büchsenstraße 20

70174 Stuttgart

BBQ und Getränke inklusive

Dieses Webinar zeigt, wie Marketing Mix Modellierung und Next Best Offers (NBOs) gemeinsam genutzt werden können, um Marketingbudgets effizient zu steuern und gleichzeitig personalisierte Angebote auszuspielen. Durch die Verbindung von strategischer Wirkungsmessung mit datengetriebener Kundeninteraktion entsteht ein ganzheitlicher Ansatz, der sowohl den ROI als auch die Kundenzufriedenheit steigert.

Souveränität ist ein zentraler Baustein für digitale Unabhängigkeit, Datenschutz und Compliance in Europa. In diesem kompakten Webinar erfahren Sie, wie Unternehmen mit STACKIT eine sichere und leistungsfähige Cloud Infrastruktur aufbauen und betreiben können. Sie lernen die wichtigsten Funktionen kennen, erfahren, wie sich STACKIT von anderen Anbietern unterscheidet und erhalten praxisnahe Hinweise für die technische Umsetzung im eigenen Unternehmen.

In 60 Minuten zeigen wir, wie Sie mit Conditional Access, sinnvollen Baseline-Policies und praxiserprobten Tipps Ihr Zugriffsmodell schnell und sicher weiterentwickeln. Kompakt, verständlich und direkt umsetzbar: kurze Zero-Trust-Einführung, konkrete Beispiele aus Microsoft 365 sowie klare Empfehlungen für Rollout, Governance und Notfallzugriffe. Ideal für IT- und Security-Verantwortliche, die ohne Buzzwords zu belastbaren Ergebnissen kommen wollen. Jetzt anmelden und Platz sichern.

Digitale Souveränität ist längst mehr als ein Schlagwort. Sie wird zum ernsthaften Treiber für Unternehmen und öffentliche Institutionen in der Schweiz. Zwischen Cloud-Abhängigkeiten, Datenschutz, KI-Regulierung und geopolitischen Spannungen stellt sich die Frage: Wie bleibt die Schweiz handlungsfähig, sicher und unabhängig in einer zunehmend digitalen Welt? In unserem Networking-Event „Digitale Souveränität in der Schweiz“ diskutieren Expertinnen und Experten aus Wirtschaft, Verwaltung und Technologie über aktuelle Herausforderungen und Lösungsansätze. Ziel ist es, einen realistischen Blick auf die Optionen und Risiken der digitalen Selbstbestimmung zu werfen und konkrete Handlungsmöglichkeiten aufzuzeigen.

Donnerstag, 19. März 2026, 18:00 Uhr

Signature by Regus

Bahnhofquai 11

Zürich

Apéro Riche und Getränke inklusive

Wenn die IT führen will, braucht sie ein Governance-Modell, das nicht nur kontrolliert, sondern aktiv lenkt. In diesem 30-minütigen Webinar lernen Sie ein praxiserprobtes Framework kennen, das durch zwei ineinandergreifende Regelkreise effektive Steuerung, Compliance und Performance ermöglicht.

Wie schaffen es erfolgreiche IT-Leiter, eine klare Linie zwischen Business-Zielen und IT-Initiativen zu ziehen? In diesem kompakten Webinar erhalten Sie ein erprobtes Framework, das Ihnen hilft, Ihre IT-Strategie strukturiert und wirksam aufzubauen – oder bestehende Strategien kritisch zu hinterfragen.

In unserem Webinar „Entra Connect“ lernen Sie die verschiedenen Authentifizierungsoptionen von Entra ID kennen. Sie erhalten eine Übersicht für einen Best Practice Ansatz zum Aufbau einer Entra Connect Bereitstellung. Nach dem Webinar haben Sie einen ersten Überblick, welche Schritte notwendig sind und kennen die wesentlichen Voraussetzungen, die dafür erfüllt sein müssen.

There are no results matching your search

RAPS hat seine Logistikprozesse am Standort Österreich erfolgreich auf ein zentrales SAP ERP System harmonisiert. Die Lagerverwaltung erfolgt über SAP MM und die Versandabwicklung über SAP LE. Im Bereich Export bestand Potenzial, Abläufe noch effizienter zu gestalten und stärker zu standardisieren, bei gleichzeitiger Beibehaltung der bewährten Flexibilität für die individuelle Beladung der LKW für einzelne Kunden. Ziel des Projekts war die Weiterentwicklung und Optimierung der Abläufe im Export-Versand sowie die Umsetzung identifizierter Verbesserung in SAP.

Das Projekt hatte das Ziel, langfristig Kosten in den Bereichen Prozesse, Daten und Support durch die Harmonisierung von Daten und Abläufen in 14 weltweiten Produktionsstandorten zu reduzieren. Besonderes Augenmerk lag dabei auf der Optimierung der Supply-Chain und Fertigung. Um dies zu erreichen, wurde ein globales Logistik-Template entwickelt und implementiert, das zunächst im Headquarter mit S/4HANA erweitert und dort eingeführt wurde, bevor es auf mehr als 14 Standorte des Unternehmens ausgerollt wurde.

Ziel des Projekts war die Evaluierung von SAP Build Process Automation im Vergleich zu bereits im Einsatz befindlichen Automatisierungstools wie Automation Anywhere und UIPath anhand der Automatisierung des BANF-Anlageprozesses via Fiori App.

Ebenfalls sollte eine Entscheidungsvorlage erstellt werden für den strategischen Einsatz von SAP Build Process Automation innerhalb produktionskritischer und unkritischer Bereiche eines Automobilherstellers.

Rollout der gesamten Defender Security Plattform. Defender for Server (Windows & Linux), Defender for Office 365 Apps, Defender for Endpoint und Defender for Identity. Es wurden alle Defender Produkte nach und nach bereitgestellt und eine zentrale Alarmierung eingerichtet.

Modernisierung der IT-Infrastruktur am Standort Köln/Bonn. Prozessanalyse nach ISO 9001 und Software-Validierung. Standardisierung von Arbeitsplätzen nach verschiedenen Anwendungsfällen. Einführung einer E-Mail Archivierung nach DSGVO. Einführung eines standortübergreifenden IT-Monitorings.

Der Kunde, der Produkte mit sehr langen Produktlebenszyklen herstellt, hatte bisher eine uneinheitliche Verwaltung über verschiedene Systeme, Prozesse und Standorte. Um eine Harmonisierung in Bezug auf Prozesse und Systeme über verschiedene Produktionsstandorte zu erreichen, wurde eine vollständig neue PLM-Landschaft mithilfe des Greenfield-Ansatzes aufgebaut. Dieser umfassende Prozess wurde durch ein strategisch ausgerichtetes Programm gesteuert, das mehr als 30 Projekte umfasste.

There are no results matching your search

Prüfen Sie mit 10 Fragen, ob Ihre IT-Strategie zukunftsfähig aufgestellt ist. Erkennen Sie, wo bereits klare Strukturen und wo Nachholbedarf besteht, um Wertbeitrag, Steuerbarkeit und Innovationskraft Ihrer IT zu stärken.

Mit dieser Checkliste legen Sie den ersten Schritt, um Ihre IT gezielt weiterzuentwickeln.

Cloud-Kosten verstehen und optimieren – darum geht es im FinOps Framework. In diesem Whitepaper geben wir Einblicke in die Ziele und Anwendung des Frameworks und wie es Unternehmen in der Kostenoptimierung für Cloud und Technologie unterstützen kann.

Erkennen Sie, wie Sie mit gezielter IT-Governance die Steuerbarkeit Ihrer IT erhöhen, Risiken kontrollieren und den Wertbeitrag Ihrer Organisation transparent machen.

Technologie allein macht noch keine Customer Experience. Dieses Whitepaper zeigt, warum der Mensch im Mittelpunkt jeder erfolgreichen CX-Initiative steht – und wie psychologische Prinzipien in Projekten und Kundeninteraktionen gezielt zum Erfolg beitragen können.

CX und ERP sind keine Gegensätze – sie sind zwei Seiten derselben Medaille. Erfahren Sie, wie Unternehmen durch die intelligente Integration von SAP S/4HANA und SAP CX nahtlose Kundenerlebnisse schaffen und gleichzeitig Prozesseffizienz und Datenqualität steigern.

Unternehmen stehen vor der Herausforderung, ihre IT-Services effizient bereitzustellen und kontinuierlich zu optimieren. IT Service Management (ITSM) spielt dabei eine zentrale Rolle, indem es strukturierte Prozesse für die Bereitstellung, Verwaltung und Verbesserung von IT-Diensten definiert.

There are no results matching your search

Mit der erweiterten macOS-Unterstützung geht Automation Anywhere deshalb einen konsequenten Schritt in Richtung echter Plattformoffenheit. Doch was bedeutet das für Unternehmen und ihre Automatisierungsstrategie?

Die Realität in Unternehmen hat sich verändert: Prozesse enden nicht mehr an Betriebssystemgrenzen. Mitarbeitende arbeiten auf Windows, macOS, mobilen Geräten und webbasierten Plattformen oft innerhalb derselben Prozesskette.

Daraus folgt:

Wenn ein kritischer Prozessschritt ausschließlich auf macOS stattfindet, kann der Automatisierungsgrad des Gesamtprozesses drastisch sinken. Genau hier setzt plattformübergreifende Automatisierung an.

Die Unterstützung von macOS ist nicht nur eine technologische Ergänzung, sondern Teil einer größeren architektonischen Entwicklung: Automatisierung soll überall dort funktionieren, wo Mitarbeitende tatsächlich arbeiten.

Die Erweiterung ermöglicht:

Damit wird Automatisierung nicht länger an die Infrastruktur gebunden, sondern zu einer universellen Fähigkeit innerhalb der IT-Architektur.

Viele Unternehmensprozesse verlaufen heute über mehrere Ebenen:

Die Einbindung von macOS sorgt dafür, dass diese Prozessketten nicht an Betriebssystemgrenzen auseinanderfallen.

Vorteile:

Insbesondere in hybriden Umgebungen kann der Automatisierungsgrad dadurch signifikant steigen.

Trotz aller neuen Möglichkeiten bringt macOS im Vergleich zu Windows andere technische und sicherheitsrelevante Rahmenbedingungen mit, darunter:

Damit macOS-Automatisierung nachhaltig funktioniert, muss sie in bestehende Sicherheits-, Betriebs- und Architekturmodelle eingebettet werden.

Die macOS-Unterstützung bei Automation Anywhere ist ein logisch konsequenter Schritt, da Arbeitsumgebungen zunehmend heterogen werden. Sie schafft die Grundlage für wirklich plattformübergreifende End-to-End-Automatisierung und adressiert damit eine der größten praktischen Hürden moderner Prozesslandschaften.

Der Mehrwert entsteht jedoch erst dann, wenn Unternehmen diese Fähigkeit strategisch, architektonisch und organisatorisch einbetten. In diesem Kontext kann macOS-Automatisierung ein wichtiger Hebel für Stabilität, Effizienz und durchgängige Automatisierungserlebnisse sein.

Mit Automation Anywhere V39 KI-Automatisierung erweitert die Automation-360-Plattform gezielt ihre Funktionen für Künstliche Intelligenz. Ziel ist es, Automatisierungen schneller, transparenter und leichter wartbar zu gestalten. V39 richtet sich insbesondere an Anwenderunternehmen, IT-Architekten und Automatisierungsverantwortliche, die ihre IT-Landschaften mit intelligenten Automatisierungen ergänzen möchten.

Im Fokus stehen:

KI-gestützte Entwicklung für Entwickler und Fachanwender

Verbesserte Dokumentenverarbeitung

Transparenter Betrieb verteilter Automatisierungslandschaften

Integration in hybride ERP- und IT-Umgebungen

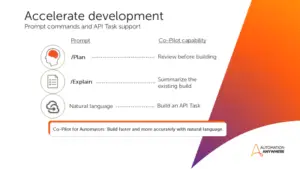

Co-Pilot für Automators wurde in V39 erheblich erweitert:

Plan-Modus: Wandelt Anforderungen in strukturierte, editierbare Automatisierungspläne um – ideal für Review und Teamabstimmung vor dem Build.

Explain-Funktion: Liefert verständliche Schritt-für-Schritt-Erklärungen für bestehende Automatisierungen – vereinfacht Debugging, Übergaben und Wartung.

API-Task-Support: Erlaubt das Erstellen, Bearbeiten und Aktualisieren von API-basierten Workflows per natürlicher Sprache.

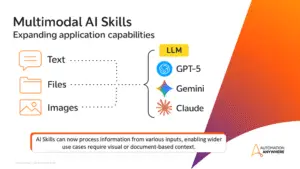

Multimodale AI Skills unterstützen nun Text, Bilder und Dateien und ermöglichen komplexe Szenarien wie Schadensanalysen, Dokumentenverarbeitung und visuelle Workflows. Entwickler können flexibel zwischen LLMs wie GPT-5, Gemini und Claude wählen.

Automator AI reduziert damit manuellen Entwicklungsaufwand, verbessert Konsistenz und beschleunigt hybride Integrationen zwischen Legacy-Software, Cloud-Services und externen Anwendungen.

V39 bringt erweiterte Funktionen für den Betrieb und die Analyse von Automatisierungen:

Process Metrics Dashboard: Überblick über Erfolgsquoten, Laufzeiten, Trends und Aging von Automatisierungen – mit Filter- und Exportfunktionen.

Mozart Orchestrator: Leistungsfähige Prozess-Orchestrierung, u.a. Universal Event Listener für Echtzeit-Auslöser in beliebigen Apps oder Systemen.

Agent Interoperability: Sichere, parallele Ausführung über mehrere Geräte und Plattformen; nahtlose Multi-Agent-Orchestrierung mit Governance und RBAC.

Diese Features sorgen für höhere Stabilität, schnellere Reaktionszeiten und bessere Analysefähigkeit in komplexen Automatisierungslandschaften.

Die Document Automation wurde in V39 stark erweitert:

Google Gemini Modelle auf AWS und GCP: Ermöglichen generative KI-gestützte Datenextraktion, unabhängig vom zertifizierten Cloud-Anbieter.

Effiziente Verarbeitung großer, unstrukturierter Dokumente

Unterstützung mehrsprachiger Dokumente

Verarbeitung komplexer Layouts

Schnellere und genauere Extraktion

Unterschied Oberfläche Document Automation V39

Version History in Test Mode: Verbesserungen ermöglichen sichere Änderungen an Lerninstanzen, automatische Validierung und korrekte Anzeige aller Versionen.

Fehlerbehebungen: Korrekte Extraktion deutscher Zeichen, Unterstützung asiatischer Zeichensätze, fehlerfreie Anpassungen von Standard Forms Projekten, stabile Adaptive Search Queries.

Generative Co-Pilot Validierung: Fehlende Signaturfelder werden korrekt erkannt und validiert.

Vorteile:

Reduzierter manueller Aufwand bei dokumentenintensiven Prozessen

Höhere Datenqualität und Genauigkeit

Flexibilität bei der Nutzung von Lerninstanzen auf verschiedenen Cloud-Plattformen

Bekannte Einschränkungen: Einige spezielle Szenarien im Testmodus, mit regulären Ausdrücken oder sehr langen Dateinamen müssen beachtet werden; Workarounds sind dokumentiert.

Die neue Version erleichtert Fachanwendern die Nutzung von Automatisierungen:

Einbettung direkt in Geschäftsanwendungen über iFrame-Widgets

Steuerung via natürlicher Sprache durch verbesserte Konversationsfunktionen

Erweiterte Wissensbasis für präzisere Automatisierungsanfragen

Das senkt die Einstiegshürde für nicht-technische Anwender und steigert die Nutzung von Automatisierungen im Fachbereich.

V39 ergänzt kontrollierte Zugriffe auf KI-Funktionen:

Generative Recorder: Zentral steuerbar und mit rollenbasierten Berechtigungen

Unterstützung für LLMs wie GPT-5, Gemini und Claude

Zugriffskontrolle und Governance über das Control Room Management

Damit wird die Zusammenarbeit zwischen Entwicklung, Betrieb und Compliance gestärkt.

Automation Anywhere V39 KI-Automatisierung vereint:

Schnellere, smartere Entwicklung

Stabilen, transparenten Betrieb

Einfache Einbindung von Fachanwendern

Besonders geeignet ist es für Unternehmen mit komplexen ERP-Landschaften, hybriden IT-Architekturen und datenintensiven Prozessen. V39 verbessert die Effizienz, Qualität und Steuerbarkeit von Automatisierungen, ohne Governance oder Nachvollziehbarkeit zu vernachlässigen.

Viele Unternehmen nutzen heute die Cloud, doch zwischen „Cloud nutzen“ und „Cloud richtig nutzen“ können Welten liegen. Während einige ihre Cloud-Infrastruktur als strategischen Vorteil einsetzen, kämpfen andere mit ineffizienten Systemen, steigenden Kosten und starren Strukturen. Der Unterschied liegt unter anderem in der Architektur: Wer von Anfang an auf eine durchdachte Cloud-Architektur setzt, schafft die Grundlage für Skalierbarkeit, Sicherheit und Effizienz. In diesem Artikel zeigen wir, was für den Aufbau einer Cloud-Architektur wichtig ist und wie die verschiedenen Ebenen zusammenwirken.

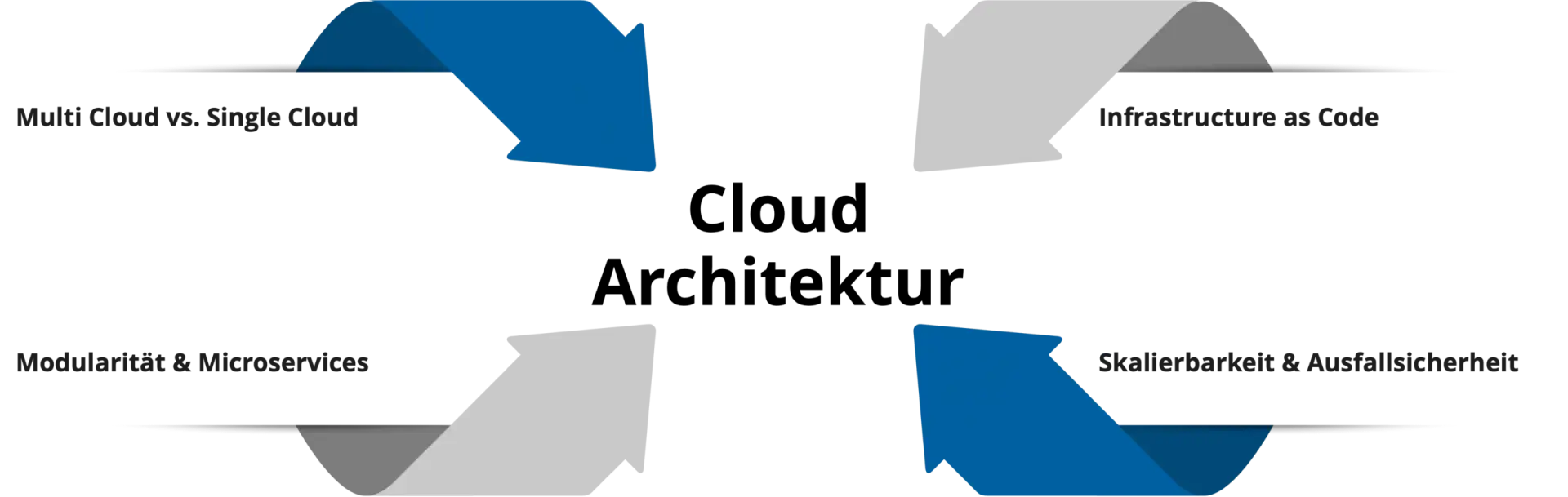

Eine zukunftssichere Cloud-Architektur entsteht durch bewusste Entscheidungen auf verschiedenen Ebenen. Von der grundlegenden Cloud-Strategie über die Anwendungsstruktur bis hin zur Automatisierung und Betriebsstabilität. Jede Ebene baut auf der vorherigen auf und trägt zum Gesamterfolg bei. Die folgenden vier Dimensionen bilden das Fundament einer leistungsfähigen Cloud-Plattform, die mit Ihrem Unternehmen wachsen kann.

Eine der ersten Fragen beim Aufbau einer Cloud-Architektur lautet: Setzen wir auf einen einzigen Cloud-Anbieter oder verteilen wir unsere Workloads auf mehrere? Beide Ansätze haben eigene Vor- und Nachteile.

Die richtige Wahl hängt von Ihren Anforderungen ab: Unternehmen mit hohen Compliance-Anforderungen oder dem Wunsch nach Souveränität tendieren zu Multi-Cloud-Ansätzen. Wer Effizienz und schnelle Markteinführung priorisiert, fährt mit einem Single-Cloud-Ansatz oft besser. Wichtig ist: Die Entscheidung sollte strategisch getroffen werden, nicht zufällig oder nach dem Bauchgefühl.

Moderne Cloud-Architekturen setzen auf Modularität statt auf monolithische Anwendungen. Das Microservices-Prinzip zerlegt komplexe Anwendungen in kleinere, eigenständige Services, die unabhängig voneinander entwickelt, deployed und skaliert werden können.

Die Vorteile liegen auf der Hand: Teams können parallel arbeiten, einzelne Komponenten lassen sich gezielt skalieren und Technologiewechsel betreffen nur Teilbereiche statt des gesamten Systems. Wenn beispielsweise der Payment-Service mehr Last erfährt als der Rest der Anwendung, skaliert nur dieser und nicht die gesamte Infrastruktur.

Allerdings bringt diese Flexibilität auch Herausforderungen mit sich. Microservices erfordern kleinteilige Orchestrierung, durchdachtes API-Design und robustes Monitoring. Microservices erfordern eine sichere und kostenbewusste Konfiguration aller Services und ihrer Interaktionen. Container-Technologien wie Kubernetes oder Cloud Foundry helfen dabei, diese Komplexität zu meistern. Für Cloud Platform Engineering sind Microservices ideal, weil sie genau die Selbstverwaltung und Autonomie ermöglichen, die Teams brauchen.

Infrastructure as Code (IaC) ist das Fundament jeder modernen Cloud-Architektur. Statt Server und Netzwerke manuell zu konfigurieren, wird die gesamte Infrastruktur in Code beschrieben. Dadurch wird sie versioniert, testbar und reproduzierbar. Darüber hinaus ermöglicht IaC alle Vorteile etablierter Softwareentwicklungs-Workflows. Änderungen können vor dem Merge geprüft, dokumentiert und freigegeben werden, Konfigurationen automatisiert getestet werden, und fehlerhafte oder unsichere Setups lassen sich erkennen, bevor sie in produktive Umgebungen ausgerollt werden.

Tools wie Terraform, Pulumi, Azure Bicep oder AWS CloudFormation ermöglichen es, Infrastruktur wie Software zu behandeln. Die Vorteile dahinter sind groß:

In Kombination mit GitOps entsteht ein besonders leistungsfähiger Ansatz: Infrastruktur-Änderungen werden ausschließlich über Git-Workflows gesteuert und von CI/CD-Pipelines automatisiert ausgerollt. Das beschleunigt Prozesse und erhöht die Sicherheit, da manuelle Eingriffe auf ein Minimum reduziert werden.

Ein zukunftssicherer Aufbau einer Cloud-Architektur muss zwei zentrale Anforderungen erfüllen: Er muss mit wachsenden Anforderungen skalieren und gleichzeitig hochverfügbar bleiben.

Wichtig ist aber: Hochverfügbarkeit hat ihren Preis. Unternehmen müssen abwägen, welche Systeme kritisch sind und welches Ausfallrisiko akzeptabel ist. Nicht jede Anwendung braucht eine >99,99%-Verfügbarkeit.

Erst das Zusammenspiel aller Elemente stellt den erfolgreichen Aufbau einer Cloud-Architektur dar. Eine durchdachte Cloud-Architektur kombiniert die richtige Cloud-Strategie mit modularem Design, automatisierter Infrastruktur und eingebauter Resilienz. Unterstützen können dabei spezielle Frameworks wie das AWS, Google oder Azure Well-Architected Framework sowie Cloud Adoption Frameworks. Diese definieren Best Practices für Sicherheit, Kostenoptimierung, Betrieb und Performance. Durch den Security by Design Ansatz sorgen sie zudem dafür, dass Sicherheit von Beginn an berücksichtigt und integriert wird.

Weiterhin wichtig ist FinOps für eine kontinuierliche Kostenoptimierung. Cloud-Ressourcen sind zwar flexibel, können aber ohne Kontrolle schnell zu Kostenexplosionen führen. Monitoring, Tagging und regelmäßige Reviews sind dazu da, ein gutes Verhältnis zwischen Performance und Wirtschaftlichkeit zu schaffen.

Im Cloud Platform Engineering geht es vor allem darum, die Cloud-Infrastruktur als Produkt zu verstehen. Sie ist eine Plattform, die kontinuierlich an die Bedürfnisse der Nutzer angepasst wird. Die optimale Cloud-Architektur gibt es deshalb nicht als Standardlösung. Jedes Unternehmen muss basierend auf seinen Anforderungen, Ressourcen und Zielen die individuell richtigen Entscheidungen treffen. Ob Single- oder Multi-Cloud, Microservices oder modulare Monolithen, umfassende Redundanz oder akzeptables Risiko, die Architektur muss zur Organisation passen.

Wichtig ist, ein Verständnis für die grundlegenden Prinzipien zu schaffen. Infrastructure as Code ermöglicht Automatisierung, Flexibilität entsteht durch Modularität und durchdachte Skalierbarkeit und Ausfallsicherheit bringen Resilienz. Durch die Berücksichtigung dieser Elemente können Unternehmen eine zukunftssichere Cloud-Architektur schaffen, die mit dem Unternehmen wächst.

Nach Jahren des infrastrukturellen Aufbaus zeigt sich 2025 deutlich, dass digitale Anwendungen der Telematikinfrastruktur im Versorgungsalltag angekommen sind. Der E-Health Monitor 2025 belegt, dass die Nutzung zentraler TI-Anwendungen insgesamt zunimmt. Gleichzeitig wird sichtbar, dass sich Nutzungsintensität und Integration aber je nach Anwendung unterscheiden.

Das E-Rezept ist die bislang am weitesten verbreitete Anwendung der Telematikinfrastruktur. Laut E-Health Monitor 2025 hat sich das digitale Rezept mit einem Anteil von 90,2 Prozent an allen eingelösten Rezepten innerhalb kurzer Zeit als Standard etabliert. Die Zahl der eingelösten E-Rezepte ist seit der verpflichtenden Einführung stark gestiegen und liegt aktuell bei 1,1 Milliarden eingelösten Rezepten.

Ein zentraler Erfolgsfaktor ist die klare Prozesslogik. Verordnung, Übermittlung und Einlösung folgen einem klar abgegrenzten Ablauf mit unmittelbarem Nutzen für alle Beteiligten. Das spart Zeit und Kosten und der Zugang zu Medikamenten wird erleichtert. Trotz der Vorteile werden weiterhin rund 10 Prozent der Rezepte ausgedruckt. Gründe hierfür sind vor allem technische Probleme innerhalb der Telematikinfrastruktur sowie die eingeschränkte Nutzbarkeit des E-Rezepts in der Haus- und Heimversorgung. Das Beispiel verdeutlicht, dass selbst bei sehr hoher Nutzung technische Stabilität und Prozessabdeckung entscheidend bleiben.

Neben dem E-Rezept verzeichnete auch die elektronische Arbeitsunfähigkeitsbescheinigung im Erhebungszeitraum des E-Health Monitors einen deutlichen Zuwachs. So stieg die Zahl der elektronisch übermittelten Arbeitsunfähigkeitsbescheinigungen von 304 auf 370 Millionen, was einem Anstieg von rund 22 Prozent entspricht. Die eAU gilt als fest etablierte Anwendung, insbesondere im ambulanten Bereich, da sie von mehr als 95% der Arztpraxen genutzt wird.

Die elektronische Patientenakte ist bundesweit im Betrieb und gilt als zentrales Element der TI-Anwendungen. Die Zahl der durch medizinische Einrichtungen geöffneten elektronischen Patientenakten ist laut E-Health Monitor 2025 innerhalb kurzer Zeit von rund 200.000 auf 7,2 Millionen gestiegen.

Gleichzeitig zeigt ein Blick auf die aktive Nutzung ein differenzierteres Bild. Lediglich rund 4 Prozent der Versicherten verfügten im Erhebungszeitraum über eine GesundheitsID. Der Unterschied zwischen angelegten und tatsächlich genutzten Akten ist damit erheblich. In vielen Fällen bleiben die Akten leer oder nur geringfügig befüllt, sodass der erwartete Nutzen der ePA bislang nur eingeschränkt realisiert wird.

Obwohl durch das Opt-out-Verfahren eine Abdeckung von über 80 Prozent erreicht wurde und nur etwa 5 Prozent der Versicherten widersprochen haben, entsteht Mehrwert erst durch tatsächliche Nutzung und Befüllung der Akten. Um das zu fördern, wurden Leistungserbringer zum 1. Oktober 2025 verpflichtet, bestimmte medizinische Informationen in die ePA einzustellen. Bei Nichtbefüllung können Sanktionen greifen. Die ePA zeigt damit besonders deutlich, dass technische Verfügbarkeit allein nicht ausreicht, sondern organisatorische und prozessuale Voraussetzungen entscheidend sind.

Die Ergebnisse des E-Health Monitor 2025 zeigen klar, dass die Nutzung von TI-Anwendungen insgesamt zunimmt, jedoch sehr unterschiedlich ausgeprägt ist. Anwendungen mit klaren, transaktionalen Prozessen wie das E-Rezept erreichen schnell hohe Akzeptanz. Komplexere Anwendungen wie die elektronische Patientenakte benötigen hingegen deutlich mehr Zeit, Integration und organisatorische Anpassung. Besonders spannend bleibt, wie sich die Nutzung der ePA in dem kommenden Jahr entwickelt und ob es gelingt, aus formaler Abdeckung tatsächlichen digitalen Mehrwert zu schaffen.

Die Digitalisierung des deutschen Gesundheitswesens hat 2025 einen Punkt erreicht, an dem Fortschritt und Ernüchterung gleichzeitig sichtbar werden. Mit der verpflichtenden Einführung zentraler Anwendungen wie E-Rezept und elektronischer Patientenakte, einer nahezu flächendeckenden Anbindung an die Telematikinfrastruktur sowie den gesetzlichen Rahmenbedingungen wie dem Digitalgesetz (DigiG), dem Gesundheitsdatennutzungsgesetz (GDNG) und dem Gesundheitsdigitalagenturgesetz (GDAG) sind die Voraussetzungen für digitale Versorgung so umfassend wie nie zuvor. Der E-Health Monitor 2025 zeigt jedoch, dass diese Infrastruktur im Versorgungsalltag bislang nur begrenzt Wirkung entfaltet.

Diese Diskrepanz ist kein kurzfristiges Umsetzungsproblem, sondern Ausdruck eines strukturellen Spannungsfeldes. Die TI wurde über Jahre primär als verpflichtende Infrastruktur etabliert, mit starkem Fokus auf Sicherheit, Regulierung und formaler Anbindung. Die Frage, wie digitale Anwendungen tatsächlich in bestehende Arbeitsabläufe integriert werden können, spielte in der frühen Phase eine untergeordnete Rolle. Entsprechend erleben viele Leistungserbringer die TI weniger als Entlastung, sondern als zusätzliche Ebene, die neben den bestehenden Prozessen betrieben werden muss.

Die Telematikinfrastruktur lässt sich als zentrales Rückgrat für digitale Kommunikation, Authentifizierung und den sicheren Austausch medizinischer Daten im Gesundheitswesen beschreiben. Technisch umfasst sie eine Vielzahl von Komponenten und Diensten von Identitätsmanagement über Kommunikationsdienste wie KIM bis hin zu Anwendungen wie ePA und E-Rezept. Die TI ist hochgradig sicherheitsorientiert und regulatorisch eng geführt. Gleichzeitig erhöht sie die technische und organisatorische Komplexität für die angeschlossenen Einrichtungen erheblich, insbesondere dort, wo neue Anwendungen tief in bestehende Systeme integriert werden müssen.

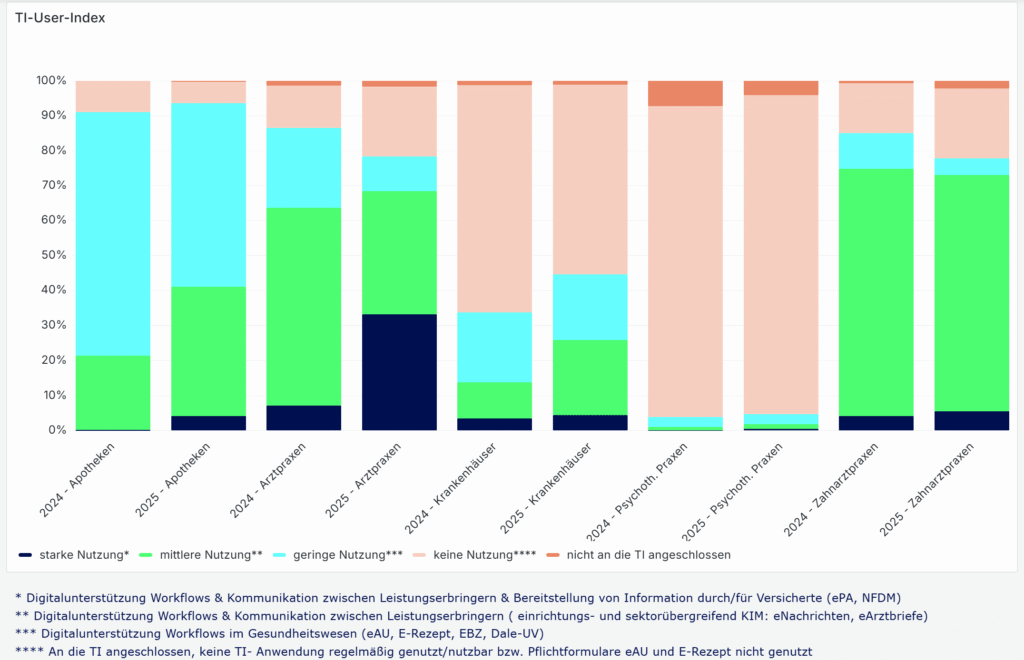

Ein zentrales Ergebnis aus den ersten Kapiteln des E-Health Monitors ist, dass die digitale Reife im Gesundheitswesen ziemlich unterschiedlich ausfällt. Der häufig pauschal beschriebene „Stand der Digitalisierung“ verdeckt erhebliche Unterschiede zwischen den Leistungserbringern. Während 64 Prozent der Praxen TI-Anwendungen zumindest regelmäßig bis intensiv nutzen, ist die Nutzungsintensität mit nur 13 Prozent der Krankenhäuser deutlich geringer. Zwar sind Krankenhäuser vollständig angebunden, doch der Anteil der Krankenhäuser, die die TI mittel bis intensiv im Alltag einsetzen, liegt deutlich unter dem ambulanten Niveau. Der TI-User-Index der gematik verdeutlicht diese Unterschiede zusätzlich: Während sich bei Arztpraxen 2025 ein deutlicher Anteil mittlerer und starker Nutzung der TI-Anwendungen zeigt, dominiert bei Krankenhäusern weiterhin der Bereich „keine Nutzung“. Selbst im Jahresvergleich 2024 zu 2025 bleibt der Anteil der TI aktiv nutzenden Kliniken gering, während Praxen ihre Nutzungsintensität sichtbar steigern konnten. Ein Befund, der vor allem die höhere strukturelle und organisatorische Komplexität des stationären Bereichs widerspiegelt.

Diese Unterschiede sind strukturell erklärbar. Ambulante Praxen arbeiten häufig mit vergleichsweise homogenen IT-Systemen und klar abgegrenzten Workflows, in die einzelne TI-Anwendungen punktuell integriert werden können. Krankenhäuser hingegen verfügen über hochkomplexe, historisch gewachsene IT-Landschaften mit zahlreichen Subsystemen, Schnittstellen und Abhängigkeiten. Neue digitale Anwendungen greifen hier in bestehende KIS-Strukturen ein, was Implementierungen zeitintensiv macht und stark von Herstellern abhängig ist. Digitale Prozesse lassen sich dadurch deutlich schwerer standardisieren und skalieren.

Hinzu kommt, dass technische Instabilitäten der TI keine Seltenheit sind. Der E-Health Monitor 2025 zeigt, dass technische Probleme bzw. die Fehleranfälligkeit für Kartenterminals und Konnektoren weiterhin ein relevanter Faktor sind.

Während Ausfälle oder Störungen im ambulanten Bereich häufig zu Mehrarbeit und Umgehungslösungen wie dem Faxgerät führen, können dieselben Probleme im stationären Umfeld ganze Prozessketten betreffen – von der Aufnahme über die Dokumentation bis hin zur Entlassung. Die Sensibilität gegenüber Systemstörungen ist entsprechend höher, was die Akzeptanz digitaler Anwendungen zusätzlich beeinflusst. Vor diesem Hintergrund ist die geringere Nutzungsintensität im stationären Bereich weniger als Defizit zu verstehen, sondern als Ausdruck der erheblich komplexeren Ausgangslage, unter der digitale Transformation im Krankenhaus stattfindet.

Diese Unterschiede spiegeln sich auch in dem TI-Atlas Dashboard der gematik wider. Zwar zeigt der „TI-Readiness-Index“, dass Apotheken, Arztpraxen und Krankenhäuser bis auf maximal 2 Prozent voll an die TI angeschlossen sind, doch der sogenannte TI-User-Index zeigt, dass aktive Nutzung und Integration stark variieren. Der TI-User-Index differenziert dabei zwischen starker, mittlerer, geringer und keiner Nutzung. Besonders auffällig ist, dass selbst bei nahezu vollständiger technischer Anbindung große Teile der Leistungserbringer TI-Anwendungen kaum oder gar nicht im Arbeitsalltag einsetzen.

TI User Index der gematik (Screenshot vom 28.12.25, aufgerufen unter: TI Atlas Dashboard)

Auch in der Nutzung einzelner TI-Anwendungen zeigen sich deutliche Unterschiede. Während E-Rezept und der KIM-Dienst vergleichsweise stark genutzt werden, bleibt die Nutzung der elektronischen Patientenakte weiterhin deutlich hinter den Erwartungen zurück.

Der Stand der Telematikinfrastruktur im Jahr 2025 ist damit weniger eine Frage fehlender Technik als fehlender struktureller Passung. Die TI-Infrastruktur ist vorhanden, doch sie ist noch nicht konsequent auf die Realität unterschiedlicher Versorgungsbereiche ausgerichtet. Digitale Reife entsteht nicht nur durch Anschlussquoten oder gesetzliche Verpflichtungen, sondern durch technische Stabilität der TI, reduzierte Komplexität und eine Integration, die sich an realen Arbeitsabläufen orientiert.

Der E-Health Monitor 2025 macht deutlich, dass sich der Schwerpunkt der Digitalisierung auch noch in eine andere Richtung verschieben muss: weg von der Frage, ob digitale Infrastruktur existiert, hin zu der Frage, wie sie genutzt wird und von wem. Erst wenn digitale Anwendungen in ambulanten und stationären Settings gleichermaßen betriebsstabil und praxistauglich integrierbar sind, kann aus technischer Anbindung, digitale Reife und digitale Versorgung werden.

Der aktuelle „Stand der Digitalisierung“ ist damit weniger als Leistungsbewertung einzelner Akteure zu verstehen, sondern als Ausdruck der Komplexität der Aufgabe insgesamt. Die Unterschiede zwischen ambulantem und stationärem Bereich verdeutlichen, dass digitale Transformation im Gesundheitswesen nur dann gelingen kann, wenn Infrastruktur, Prozesse und organisatorische Realität konsequent zusammengedacht werden. Insbesondere dort, wo komplexe klinische Abläufe, hohe Integrationsanforderungen und kritische Versorgungsprozesse aufeinandertreffen

Der Austritt von Mitarbeitenden stellt IT-Abteilungen regelmäßig vor eine sensible Aufgabe. Geschäftskritische Dokumente liegen häufig im persönlichen OneDrive-Konto und müssen rechtzeitig, vollständig und nachvollziehbar an Nachfolger oder Führungskräfte übergeben werden. In der Praxis ist dieser Prozess jedoch oft fehleranfällig: Benachrichtigungen werden übersehen, Dateien werden nur kopiert statt sauber übertragen oder bestehende Freigaben gehen verloren.

Mit dem Microsoft Message Center Update MC1164381 adressiert Microsoft genau diese Herausforderungen und verbessert den Offboarding-Prozess rund um OneDrive spürbar.

Das Update verfolgt ein klares Ziel: Die Übergabe von Dateien ausscheidender Mitarbeitender soll einfacher, transparenter und weniger abhängig von manuellen Einzelschritten sein. Gleichzeitig möchte Microsoft sicherstellen, dass bestehende Zusammenarbeit (insbesondere durch Freigaben) möglichst unterbrechungsfrei fortgesetzt werden kann. Dabei handelt es sich nicht um eine neue Funktion im engeren Sinne, sondern um eine gezielte Weiterentwicklung bestehender Mechanismen, die im Alltag vieler Organisationen bislang nur eingeschränkt zuverlässig funktioniert haben. Der Rollout der Änderungen begann Mitte Oktober 2025 und soll nach aktuellem Stand bis Ende Januar 2026 vollständig abgeschlossen sein. Die Funktionen werden automatisch im Tenant aktiviert; eine gesonderte Konfiguration oder Lizenzanpassung ist nicht erforderlich. Für IT-Abteilungen bedeutet das: Die Neuerungen kommen, unabhängig davon, ob bestehende Prozesse bereits darauf vorbereitet sind.

Eine der zentralen Änderungen betrifft die Benachrichtigungen im Rahmen des sogenannten Account-Cleanup-Prozesses. Wird ein Benutzerkonto gelöscht, delegiert Microsoft den Zugriff auf das zugehörige OneDrive automatisch an den in Entra ID hinterlegten Manager oder an einen definierten sekundären Besitzer. Die entsprechenden E-Mails werden künftig deutlich auffälliger gestaltet. Hintergrund ist eine bekannte Schwachstelle: In vielen Organisationen hängt die gesamte Dateiübergabe faktisch an einer einzelnen E-Mail. Wird diese übersehen, verstreicht die Retentionsfrist, und Daten gehen unwiederbringlich verloren. Durch die verbesserte Sichtbarkeit soll dieses Risiko deutlich reduziert werden.

Zusätzlich verbessert Microsoft die Benutzeroberfläche für Manager und Owner, die Zugriff auf das OneDrive eines ausgeschiedenen Mitarbeiters erhalten. Neue Filteroptionen erleichtern es, gezielt nach freigegebenen oder besonders relevanten Dateien zu suchen. Statt sich durch eine vollständige Ordnerstruktur arbeiten zu müssen, können Verantwortliche schneller erkennen, welche Inhalte tatsächlich in der Zusammenarbeit genutzt wurden. Das spart Zeit und reduziert die Gefahr, wichtige Dateien zu übersehen.

Eine besonders praxisrelevante Neuerung ist die erweiterte Möglichkeit, mehrere Dateien gesammelt zu verschieben und dabei bestehende Freigaben beizubehalten. Microsoft beschreibt diesen Vorgang ausdrücklich als echtes „Verschieben“ und nicht als Kopieren.

Auch die Kommunikation an bestehende Kollaborierende wurde überarbeitet. Werden mehrere Dateien gleichzeitig verschoben, erhalten die betroffenen Nutzer künftig eine zusammengefasste Benachrichtigung anstelle vieler einzelner E-Mails. Das reduziert nicht nur die E-Mail-Flut, sondern erhöht auch die Akzeptanz solcher Übergabeprozesse im Fachbereich. Änderungen an Dateiablagen werden transparenter wahrgenommen, ohne als störend empfunden zu werden.

Der grundsätzliche Ablauf nach dem Löschen eines Benutzerkontos bleibt bestehen, wird jedoch klarer kommuniziert. Nach der automatischen Zugriffserteilung informiert Microsoft über die geltende OneDrive-Retention. Zusätzlich erfolgt sieben Tage vor Ablauf eine Erinnerung, dass das OneDrive bald gelöscht wird. In vielen Tenants beträgt diese Frist standardmäßig 30 Tage, kann jedoch über Richtlinien angepasst werden. Entscheidend ist dabei weniger die Frist selbst, sondern die organisatorische Vorbereitung: Ist ein Manager im Benutzerprofil gepflegt? Gibt es einen sekundären Owner als Fallback? Ohne diese Zuordnungen kann auch der verbesserte Prozess seine Wirkung nicht entfalten.

MC1164381 ist kein spektakuläres Feature-Release, aber ein sehr praxisnahes Update. Microsoft greift typische Probleme aus dem Offboarding-Alltag auf und reduziert den manuellen Aufwand für IT, Führungskräfte und Fachbereiche spürbar. Für Sie als Organisation ist dies ein guter Anlass, bestehende Offboarding-Prozesse zu überprüfen. Sind Verantwortlichkeiten klar definiert? Werden Benutzerprofile sauber gepflegt? Und liegen geschäftskritische Inhalte überhaupt am richtigen Ort? Wenn diese Grundlagen stimmen, entfaltet das Update seinen vollen Nutzen und trägt dazu bei, Datenverluste, operative Hektik und unnötige Nacharbeiten beim Mitarbeiteraustritt deutlich zu reduzieren.

Bei Fragen oder Anregungen zum Thema New Work, zur Microsoft Welt oder zu Collaboration Tools stehen wir Ihnen gerne beratend zur Seite. Wir freuen uns auf Ihre Kontaktaufnahme. Weitere Blogartikel aus Bereichen, die von New Work, über Microsoft 365 bis hin zu Sustainable IT reichen, finden Sie auf unserer Blogseite.

Die Cloud-Transformation verspricht Flexibilität, Skalierbarkeit und Kosteneffizienz. Bei der Migration ihrer IT-Infrastruktur in die Cloud zögern trotzdem nach wie vor viele Unternehmen. Sie haben Sicherheitsbedenken, befürchten Kontrollverluste und haben Angst vor unkalkulierbaren Kosten. Hier stellt sich allerdings die Frage: Sind diese Einwände noch berechtigt oder gibt es inzwischen für alle Cloud-Herausforderungen Lösungen? Wir thematisieren heute die häufigsten Bedenken rund um die Cloud und zeigen, wie vermeintliche Nachteile in der Cloud überwunden oder sogar in Vorteile umgewandelt werden können.

Ob in der Führungsebene oder in einzelnen Teams: Skepsis gegenüber der Cloud gibt es immer wieder. Die Einwände sind dabei in der Regel begründet und basieren auf realen Problemen und Herausforderungen. Besonders häufig nennen Unternehmen hier Sicherheitsrisiken, unübersichtliche Kosten, den Verlust direkter Kontrolle über die IT-Infrastruktur und die Abhängigkeit von einzelnen Anbietern. Wir erklären, was es mit diesen Nachteilen in der Cloud auf sich hat und wie Unternehmen sie adressieren können.

Die Sorge um Datensicherheit und Datenschutz steht oft an erster Stelle. Unternehmen haben Angst vor Cyberangriffen, Datenlecks oder unautorisiertem Zugriff auf sensible Daten. Professionelle Cloud-Anbieter investieren jedoch erheblich mehr in Sicherheitsmaßnahmen als es den meisten Unternehmen überhaupt intern möglich wäre. Moderne Cloud-Plattformen gehen Sicherheitsrisiken durch Verschlüsselung, Multi-Faktor-Authentifizierung, kontinuierliche Sicherheitsupdates und Compliance-Zertifizierungen nach internationalen Standards an.

Tipps für diese Herausforderung:

Die Kostenstruktur von Cloud-Infrastrukturen bereitet Unternehmen ebenfalls Sorgen. Traditionelle IT-Investitionen scheinen kalkulierbar und simpel, Cloud-Abrechnungen hingegen scheinen unübersichtlich und können durch nutzungsabhängige Abrechnungsmodelle zur Kostenfalle werden. Wichtig ist an dieser Stelle vor allem ein durchdachtes Finanzmanagement von Beginn an. Denn ohne Überwachung und Optimierung können Ausgaben tatsächlich schnell und unkontrolliert ansteigen.

Tipps für diese Herausforderung:

Beim Umstieg auf eine Cloud-Infrastruktur steht die IT-Infrastruktur nicht mehr im eigenen Rechenzentrum. Das sorgt für einen gefühlten Kontrollverlust und die Sorge, die Kontrolle über kritische Systeme abzugeben. Cloud-Plattformen stellen ihren Kunden jedoch umfassende Management-Tools, detaillierte Monitoring-Dashboards und APIs zur Automatisierung zur Verfügung, die schlussendlich sogar oft mehr Transparenz und Kontrolle schaffen als klassischen On-Premises-Lösungen.

Tipps für diese Herausforderung:

Die Sorge vor einem Vendor Lock-In ist durchaus begründet. Sind Unternehmen zu stark an einen einzelnen Cloud-Anbieter gebunden, erschwert das den potenziellen Wechsel zu anderen Anbietern und kann dadurch für hohe Kosten sorgen. Souveräne Cloud-Lösungen, die die Unabhängigkeit in verschiedenen Bereichen stärken, sind deshalb heute immer gefragter.

Tipps für diese Herausforderung:

Neben konkreten Einwänden stehen viele Unternehmen vor und während der Cloud-Transformation immer wieder vor Herausforderungen, sowohl technisch als auch organisatorisch. Strategische Planung und strukturiertes Vorgehen während der Transformation sind daher umso wichtiger, um die Vorteile der Cloud zu nutzen. Wir haben einige Tipps für Sie zusammengestellt.

Die technische Migration in die Cloud ist komplex und erfordert deshalb eine umfassende Planung. Legacy-Systeme müssen möglicherweise refaktoriert werden, Datenmigrationen erfordern sorgfältige Vorbereitung und bei der Integration mit bestehenden Systemen spielt die Kompatibilität eine wichtige Rolle. IT-Teams setzen sich mit Themen rund um Netzwerklatenz, Bandbreitenbeschränkungen und die Anpassung an cloud-native Architekturen auseinander und haben die Aufgabe, Sicherheits- und Compliance-Anforderungen in der neuen Umgebung zu gewährleisten. Benötigt wird dafür spezialisiertes Know-how, das viele Unternehmen in einem Cloud-Dienstleister suchen.

Tipps für technische Herausforderungen rund um die Cloud:

Dass die Cloud-Transformation nicht einfach ein einmaliges, technisches Projekt ist, ist längst kein Geheimnis mehr. Für eine erfolgreiche Cloud-Transformation benötigt es einen kulturellen Wandel, indem Mitarbeitende neue Arbeitsweisen erlernen und agiler sowie abteilungsübergreifender zusammenarbeiten. Um möglichen Widerständen frühzeitig zu begegnen, sind Change Management, klare Kommunikation und die Einbindung aller relevanten Mitarbeitenden entscheidend. Außerdem braucht es neue Verantwortlichkeiten für die Cloud-Umgebung und Transformation, sodass Prozesse und Best Practices entwickelt werden können.

Tipps für organisatorische Herausforderungen rund um die Cloud:

Bei den Nachteilen in der Cloud – ob Kontrollverlust, Vendor Lock-In, Sicherheit oder Kosten – handelt es sich letztendlich um Herausforderungen, denen Unternehmen sich während der Cloud-Transformation stellen müssen. Für die verschiedensten Einwände gibt es Lösungen in modernen Cloud-Ansätzen, die allerdings auch umgesetzt und gelebt werden müssen. Wichtig ist dabei vor allem eine durchdachte Planung, die sowohl technische als auch organisatorische Punkte berücksichtigt, ebenso wie eine klare Bewertung, in welchen Bereichen der Einsatz der Cloud sinnvoll ist und wo möglicherweise hybride Lösungen der richtige Weg sind, um sich nicht vollständig von gewohnten On-Premises-Umgebungen abzuwenden.

Rewion begleitet Ihr Unternehmen auf dem Weg in die Cloud. Mit umfassender Expertise in der Cloud-Transformation unterstützen wir Sie von der Strategieentwicklung über die Migration bis zum laufenden Betrieb und sorgen so dafür, dass Sie die Vorteile der Cloud optimal für sich nutzen können.

Die Absicherung von E-Mails gehört zu den wichtigsten Sicherheitsmaßnahmen in jeder Organisation. Angriffe über Phishing, Spoofing oder kompromittierte Accounts gehören nach wie vor zu den größten Bedrohungen für Unternehmen – unabhängig von deren Größe. Ein zentraler Baustein zum Schutz vor solchen Angriffen ist DomainKeys Identified Mail (DKIM). DKIM stellt sicher, dass ausgehende E-Mails kryptografisch signiert werden und der Empfänger prüfen kann, ob die Nachricht tatsächlich von Ihrer Domain stammt und auf dem Transportweg nicht verändert wurde.

Allerdings reicht es nicht aus, DKIM einmalig zu aktivieren. Viele Organisationen richten DKIM ein und lassen die Konfiguration anschließend über Jahre unverändert. Das führt dazu, dass die kryptografischen Schlüssel veralten oder die Schlüssellänge nicht mehr den aktuellen Empfehlungen entspricht. Genau hier kommt die DKIM Key Rotation ins Spiel. Die regelmäßige Rotation sorgt dafür, dass die dahinterliegende Kryptografie robust bleibt, Angriffsflächen minimiert werden und Ihre Domain-Reputation geschützt wird.

Ein häufiger Grund, weshalb Unternehmen sich mit ihrem DKIM-Eintrag auseinandersetzen müssen, ist die zu kurze Schlüssellänge. Ältere DKIM-Konfigurationen verwenden oft noch 1024-Bit-Schlüssel. Diese Länge galt einst als ausreichend, wird heute aber als nicht mehr zeitgemäß betrachtet. Moderne Sicherheitsrichtlinien empfehlen durchgängig 2048-Bit-Schlüssel, da diese kryptografisch deutlich stärker sind und besser gegen mögliche Angriffe schützen. Auch viele E-Mail-Anbieter und Spamfilter bewerten zu kurze DKIM-Schlüssel zunehmend negativ, was letztlich die Zustellbarkeit beeinträchtigen kann. Daher ist es sinnvoll, regelmäßig zu prüfen, welche Schlüssellänge in Ihrer DKIM-Konfiguration hinterlegt ist. Schon die einfache Abfrage eines TXT-Records im DNS zeigt Ihnen, ob Ihr Schlüssel veraltet ist und dringend rotiert werden sollte.

Ansonsten geht es natürlich auch direkt über Powershell. Dazu muss sich zunächst mit Exchange Online verbunden werden und danach über DkimSigningConfig die aktuelle Schlüssellänge für alle Domänen, bei den aktuell DKIM konfiguriert ist, ausgelesen werden.

Get-DkimSigningConfig | Format-Table Identity, Selector1KeySize, Selector2KeySize

Wenn bei Selector1KeySize und Selector2KeySize jeweils anstelle von 2048 noch 1024 steht, sind die Gründe für eine zeitige DKIM Key Rotation noch größer.

Wenn Sie DKIM-Schlüssel in Microsoft 365 rotieren möchten, bietet das Security-Portal einen klar strukturierten Prozess. Sie finden die entsprechenden Einstellungen im Microsoft 365 Defender Portal unter „E-Mail & Kollaboration“ und dann unter den „Bedrohungsrichtlinien“. Dort können Sie unter „E-Mail authentication setting“ die DKIM-Konfigurationen Ihrer Domains verwalten.

Für jede Domain stellt Microsoft zwei Selektoren bereit, typischerweise selector1 und selector2. Über die Funktion zur Rotation generiert Microsoft automatisch einen neuen DKIM-Schlüssel. Allerdings immer nur für einen der beiden Selectoren. Die zweite Rotation muss vier Tage später erfolgen! Dieser Ablauf stellt sicher, dass der alte Schlüssel so lange gültig bleibt, bis der neue ohne Unterbrechung übernommen werden kann. Auf diese Weise wird die Signierung nicht unterbrochen, und die E-Mail-Kommunikation bleibt jederzeit abgesichert. Problematisch es nur, wenn ich gleichzeitig auch die Key-Size ändern möchte, denn das kann ich nur über Powershell machen.

Neben der Änderung der Schlüssellänge ist die Nutzung der Powershell besonders praktisch, wenn Sie mehrere Domains verwalten oder Vorgänge automatisieren möchten. Über den Befehl Connect-ExchangeOnline stellen Sie zunächst die Verbindung her. Nachdem wir bereits, wie zuvor beschrieben, die Keys ausgelesen haben, können wir anschließend mit Rotate-DkimSigningConfig -Identity „Rewion.com“ -KeySize „2048“ („Rewion.com“ hier nur als Beispiel), den ersten DKIM-Schlüssel rotieren lassen und gleichzeitig dessen Schlüssellänge auf 2048-Bit festlegen. Um zu überprüfen, ob die Anpassung der Schlüssellänge erfolgreich war, können Sie erneut Get-DkimSigningConfig | Format-Table Identity, Selector1KeySize, Selector2KeySize verwenden. Auch hier bitte daran denken, dass die zweite Rotation vier Tage später erfolgen muss und der zweite 1024-Bit Wert so lange bestehen bleiben würde, bzw. der zweite 2024-Bit Key weiterhin denselben öffentlichen Schlüssel behält.

Ob der eine Schlüssel erfolgreich rotiert wurde, ist daraufhin öffentlich abfragbar. Dazu gibt es diverse Websites, die es anbieten, den eignen DKIM-Eintrag abzufragen. Beispielsweise können Sie Mxtoolbox.com oder DMARCadvisor.com nutzen.

Die regelmäßige DKIM Key Rotation sorgt also dafür, dass Ihre Organisation langfristig geschützt bleibt. Angesichts der zunehmenden Zahl an Angriffen, die auf schwache oder veraltete Kryptografie abzielen, ist dieses Thema keinesfalls optional. Eine saubere DKIM-Konfiguration stärkt die Vertrauenswürdigkeit Ihrer E-Mails, verbessert die Zustellbarkeit und stellt die Einhaltung moderner Sicherheitsstandards sicher. Es lohnt sich daher, Ihre bestehenden DKIM-Einträge zu überprüfen und – falls notwendig – unverzüglich auf 2048-Bit-Schlüssel umzustellen. Durch die angebotenen Werkzeuge im Security Portal oder in PowerShell lässt sich dieser Prozess effizient und mit überschaubarem Aufwand umsetzen. Wenn Sie möchten, unterstützen wir Sie gerne bei der Umsetzung.

Bei Fragen oder Anregungen zum Thema New Work, zur Microsoft Welt oder zu Collaboration Tools stehen wir Ihnen gerne beratend zur Seite. Wir freuen uns auf Ihre Kontaktaufnahme.

Weitere Blogartikel aus Bereichen, die von New Work, über Microsoft 365 bis hin zu Sustainable IT reichen, finden Sie auf unserer Blogseite. Bleiben Sie des Weiteren auf dem aktuellen Stand und folgen Sie uns auf LinkedIn.

There are no results matching your search

Für den erfolgreichen Einsatz von Strategien, Technologien und Konzepten in Ihrem Unternehmen.

Willkommen bei unserem exklusiven Support für Bestandskunden. Hier finden Sie alle nötigen Informationen, um schnell und unkompliziert Hilfe bei technischen Anfragen zu erhalten.

Senden Sie uns Ihr Anliegen mit allen relevanten Details an:

Für eine direkte Unterstützung per Fernwartung, laden Sie bitte unser TeamViewer-Modul herunter:

Bitte beachten Sie: Dieser Kanal ist speziell für technische Anfragen unserer Bestandskunden vorgesehen. Für allgemeine Anfragen, Informationen zu unseren Dienstleistungen oder eine Erstberatung nutzen Sie bitte unser Kontaktformular oder schreiben Sie eine E-Mail an info@rewion.ucepts.de.